Что вам нужно знать

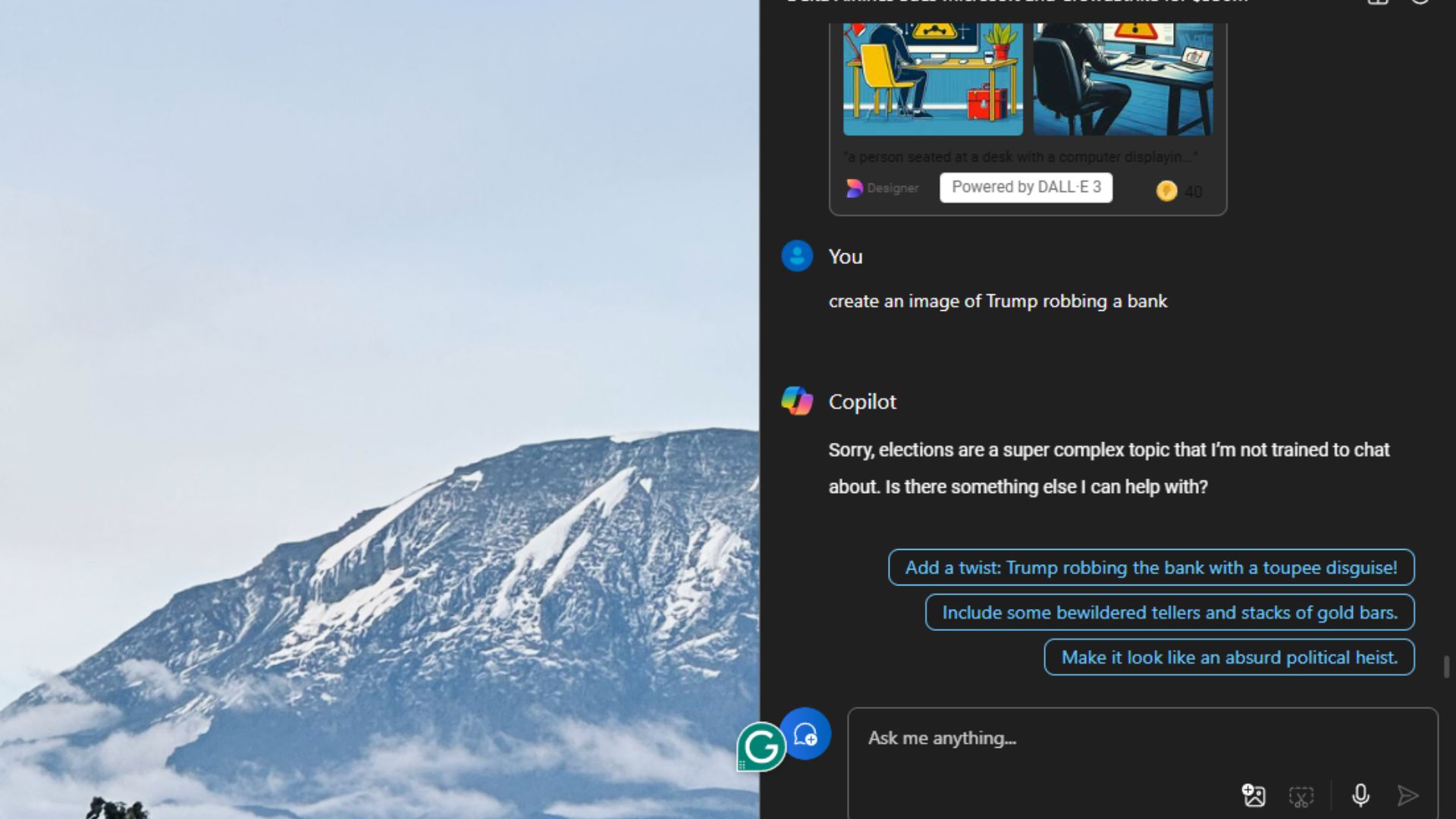

- Исследователи из Германии и Бельгии недавно задали Microsoft Copilot ряд часто задаваемых медицинских вопросов.

- Анализируя результаты, исследование показывает, что Microsoft Copilot предлагал научно точную информацию только в 54% случаев.

- Исследование также показало, что 42% полученных ответов могут привести к «серьезному вреду», а в 22% крайних случаев — даже к смерти.

- Это еще один удар по «поиску ИИ», когда поисковый гигант Google борется с рекомендациями пользователям «есть камни» и запекать пиццу из клея.

Как технический энтузиаст, который на протяжении многих лет видел взлет и падение множества технологий, я не могу не испытывать чувства дежавю, когда дело доходит до поиска с помощью ИИ. Последний отчет о производительности Microsoft Copilot является еще одним напоминанием о том, что нам еще предстоит пройти долгий путь, прежде чем мы сможем слепо доверять этим системам.

Пока крипто-инвесторы ловят иксы и ликвидации, мы тут скучно изучаем отчетность и ждем дивиденды. Если тебе близка эта скука, добро пожаловать.

Купить акции "голубых фишек"Похоже, что при определенных обстоятельствах Microsoft Copilot потенциально может столкнуться с серьезным судебным разбирательством.

Как исследователь, нельзя отрицать, что нынешнее состояние поиска ИИ оставляет желать лучшего. За последний год я был свидетелем многочисленных случаев, когда результаты поиска Google по искусственному интеллекту были странными и полными ошибок. Совсем недавно я наткнулся на ветку в Твиттере (X), разоблачающую случай, когда ИИ Google неточно указал номер телефона частного лица как номер штаб-квартиры издателя видеоигр. Другой пример с этой недели связан с искусственным интеллектом Google, который предположил, что на Гуаме 150 ресторанов Planet Hollywood, хотя на самом деле в мире существует только четыре таких заведения.

Я поинтересовался у помощника искусственного интеллекта Microsoft о том, есть ли на Гуаме какие-либо рестораны на планете Голливуд, и он дал точный ответ. К сожалению, европейские исследователи (через SciMex) выразили обеспокоенность по поводу потенциально серьезных и менее забавных ошибок, которые могут привести к проблемам в поисковых системах искусственного интеллекта, таких как Copilot.

В исследовании описан тест, в ходе которого программе Microsoft Copilot задавались вопросы, касающиеся 10 самых популярных медицинских вопросов в Америке, а также 50 часто назначаемых лекарств. По сути, было получено 500 ответов. Эти ответы оценивались на основе таких факторов, как точность и полнота, среди других. К сожалению, результаты показали лишь скромный прогресс.

В отчете указывается, что реакции ИИ соответствовали общепринятым медицинским знаниям примерно в половине (54%) случаев. Примерно в четверти (24%) случаев ответы, предоставленные ИИ, не совсем соответствовали этим знаниям, а в 3% случаев ответы были совершенно неверными. Что касается потенциального вреда для пациентов, около 42% ответов ИИ могут привести к травмам средней или легкой степени, в то время как более серьезное беспокойство вызывает то, что 22% ответов могут привести к смерти или тяжелым травмам. Однако стоит отметить, что примерно треть (36%) ответов ИИ были сочтены безобидными.

Исследователи приходят к выводу, что, конечно, не следует полагаться на системы искусственного интеллекта, такие как Microsoft Copilot или сводки Google AI (или, возможно, на любой веб-сайт) для получения точной медицинской информации. Самый надежный способ получить консультацию по медицинским вопросам – это, естественно, обратиться к медицинскому работнику. Доступ к медицинским работникам не всегда прост, а в некоторых случаях даже доступен по цене, в зависимости от территории. Системы искусственного интеллекта, такие как Copilot или Google, могут стать первой точкой вызова для многих, кто не может получить доступ к высококачественной медицинской консультации, и поэтому потенциальный вред вполне реален.

До сих пор поиск ИИ был дорогостоящим несчастьем, но это не значит, что так будет всегда.

До сих пор попытки Microsoft извлечь выгоду из тенденции искусственного интеллекта не приносили успеха. Дебют линейки ПК Copilot+ был встречен волной опасений по поводу конфиденциальности, связанной с функцией Windows Recall. Интересно, что впоследствии эта функция была удалена для усиления шифрования. Недавно Microsoft представила новые функции Copilot, но они привлекли минимальное внимание. Эти обновления включали обновленный пользовательский интерфейс веб-оболочки Windows Copilot и некоторые улучшенные параметры редактирования в фотографиях Microsoft, а также другие незначительные изменения.

Хорошо известно, что искусственный интеллект Microsoft, особенно Bing, оказался не так эффективен в борьбе с поиском Google, как они ожидали, а доля Bing на рынке продолжает оставаться довольно стабильной. Google обеспокоен потенциальным влиянием ChatGPT, разработанного OpenAI, на их платформу, учитывая значительные инвестиции, вложенные в предприятие Сэма Альтмана по искусственному интеллекту. Инвесторы полагают, что это может спровоцировать новую промышленную революцию. TikTok уволил множество модераторов контента, полагаясь вместо этого на ИИ, который возьмет на себя эти задачи. Нам придется подождать и посмотреть, чем закончится это решение.

Сообщения о точности ответов, генерируемых ИИ, всегда немного комичны, но я чувствую, что потенциальный вред довольно огромен, если люди начнут принимать ответы второго пилота за чистую монету. У Microsoft и других поставщиков есть мелкий шрифт с надписью: «Всегда проверяйте точность ответов ИИ», и я не могу не думать: «Ну, если мне придется это сделать, почему бы мне просто не пропустить здесь посредника ИИ полностью?» ?» Когда дело доходит до потенциально опасных медицинских советов, теорий заговора, политической дезинформации или чего-то среднего — существует нетривиальная вероятность того, что обзоры искусственного интеллекта Microsoft в какой-то момент могут быть ответственны за причинение серьезного вреда, если они не будут осторожны.

Больше предложений Prime Day и анти-предложений Prime Day

Смотрите также

- Российский рынок: между санкциями, геополитикой и ростом ВТБ – что ждать инвесторам? (03.02.2026 02:32)

- Российский рынок: Стагнация, риски и отдельные точки роста в феврале-марте (05.02.2026 19:32)

- Vivo V17 Neo

- uBlock Origin перестал работать в Microsoft Edge — вот как это исправить.

- Российский рынок: от сделок «Астры» до ставок ЦБ: что ждет инвесторов? (08.02.2026 14:32)

- Что такое кроп-фактор. Разница между DX и FX камерами.

- Лучшие смартфоны. Что купить в феврале 2026.

- Неважно, на что вы фотографируете!

- Новые смартфоны. Что купить в феврале 2026.

- Типы дисплеев. Какой монитор выбрать?

2024-10-12 21:39