Если вы планируете использовать Ollama для запуска больших языковых моделей локально на своем компьютере, особенно на системах Windows, у вас есть два возможных метода. Первый вариант предполагает простое использование приложения Windows напрямую. Альтернативно, вы можете выбрать запуск версии для Linux внутри Windows Subsystem for Linux (WSL).

Пока крипто-инвесторы ловят иксы и ликвидации, мы тут скучно изучаем отчетность и ждем дивиденды. Если тебе близка эта скука, добро пожаловать.

Купить акции "голубых фишек"Начальная настройка, несомненно, более проста. Для начала, не требуется предварительно устанавливать подсистему Windows для Linux (WSL). Кроме того, процедура приведения системы в рабочее состояние менее сложна. Вам просто нужно скачать установщик для Windows, запустить его, и всё готово!

Установка Ollama на WSL включает в себя несколько дополнительных шагов, но хорошо работает с Ubuntu и обеспечивает исключительную производительность (особенно при использовании видеокарты NVIDIA). Однако, если вы не разработчик, который предпочитает WSL для своих рабочих процессов, обычно нет особых преимуществ в использовании версии для WSL по сравнению со стандартной версией для Windows.

Настройка Ollama на WSL

В этой статье я дам несколько общих указаний о том, как настроить Ollama на WSL, но не затрону все аспекты. Если вы планируете использовать Ollama в подсистеме Windows для Linux (WSL), особенно с Ubuntu, поскольку это, по-видимому, самый простой и хорошо документированный вариант, есть несколько предварительных шагов, которые необходимо выполнить. Это руководство специально предназначено для видеокарт NVIDIA.

Проще говоря, я предоставлю вам базовый план настройки Ollama на WSL с использованием Ubuntu, но не охвачу каждую деталь. Здесь основное внимание уделяется видеокартам NVIDIA и процессу настройки с WSL.

Первый пункт – это недавно обновленный графический драйвер NVIDIA, совместимый с Windows. Второй – это набор инструментов CUDA, настроенный для WSL (Подсистема Windows для Linux). Если у вас есть оба этих компонента, то как будто произойдет волшебство автоматически. Хорошей отправной точкой будет изучение документации, предоставленной Microsoft и NVIDIA, для получения пошаговой инструкции по этому процессу.

Процесс не особенно длительный, но его успешное завершение и загрузка всех необходимых файлов зависят от качества вашего интернет-соединения.

Хотя это не займет много времени, скорость получения необходимых файлов зависит от мощности вашего интернет-соединения.

После того, как вы со всем разберетесь, смело запускайте скрипт установки, который поможет вам настроить Ollama в вашей системе. Имейте в виду, что я не изучал запуск Ollama внутри контейнера на WSL; мои знания об этом ограничены прямой установкой на Ubuntu.

В процессе настройки система автоматически обнаружит графическую карту NVIDIA, при условии, что все необходимые конфигурации установлены. Вы увидите сообщение с надписью «Графическая карта NVIDIA установлена», пока скрипт продолжает выполняться.

В дальнейшем работа аналогична запуску Ollama на Windows, за исключением отсутствия графического пользовательского интерфейса (GUI). Вы можете начать с загрузки вашей начальной модели, и все готово. Однако стоит отметить, что при переключении обратно на Windows может быть небольшое отличие в работе.

Когда вы используете WSL (Подсистему Windows для Linux) в отдельном окне, Ollama внутри Windows будет распознавать только те модели, которые вы установили в WSL, как активные. Если вы проверите команду `ollama list`, вы не найдете модели, установленные в вашей обычной системе Windows. Попытка запустить модель, которая, как вы знаете, установлена, может привести к ее повторной загрузке.

Чтобы убедиться, что Ollama правильно работает в Windows, необходимо сначала корректно закрыть среду WSL. Это можно сделать, введя команду «wsl shutdown» в окне PowerShell.

Практически идентичная производительность в WSL по сравнению с использованием Ollama в Windows.

Позвольте мне предоставить некоторые цифры в ближайшее время, но сначала хочу подчеркнуть незначительную, но важную деталь: Запуск подсистемы Windows для Linux (WSL) потребляет часть общих системных ресурсов. Хотя это может и не сильно повлиять на общую картину, важно знать об этом потреблении ресурсов.

В приложении настроек WSL вы можете легко настроить выделение оперативной памяти и потоков процессора для WSL в соответствии с вашими предпочтениями. Если вы в основном сосредоточены на задачах, интенсивно использующих графический процессор, эти настройки могут быть не столь важными. Однако, если вы планируете работать с моделями, которые превышают объем вашей видеопамяти, необходимо выделить WSL достаточно ресурсов для компенсации.

Имейте в виду, что если модель превысит лимит VRAM, Olama может использовать стандартную память компьютера вместе с ЦП. Поэтому убедитесь, что вы правильно выделили память.

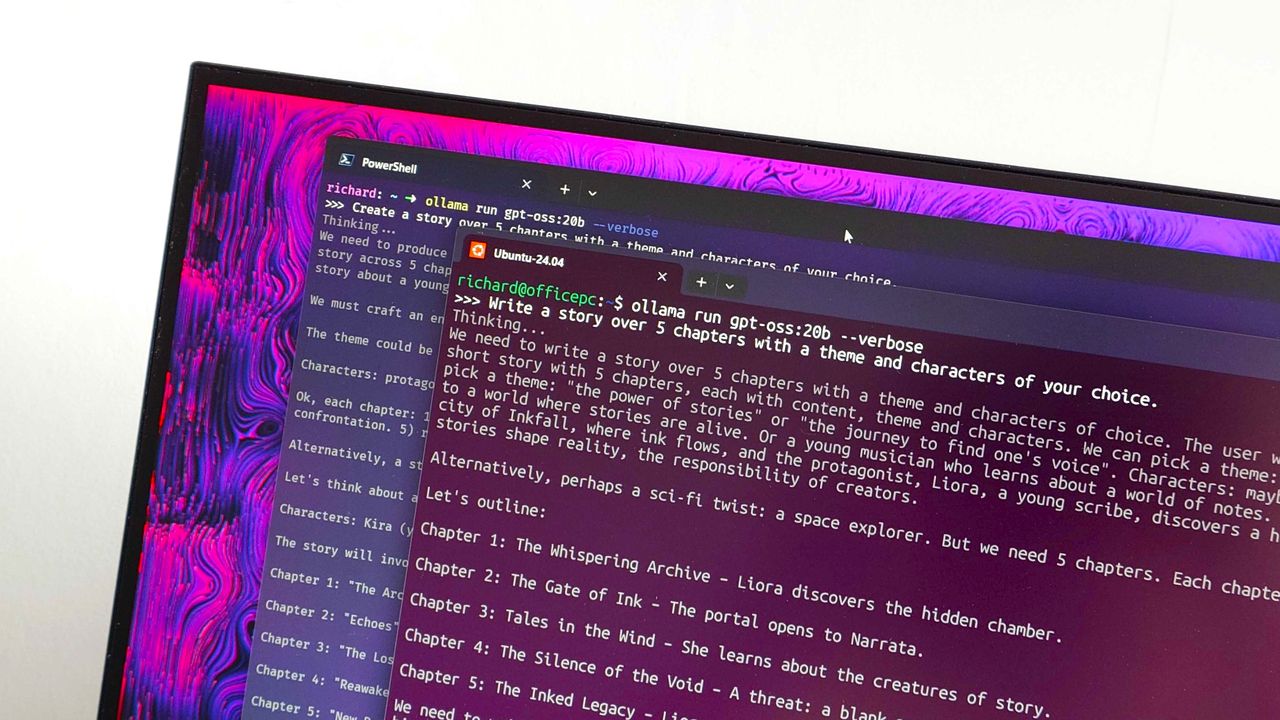

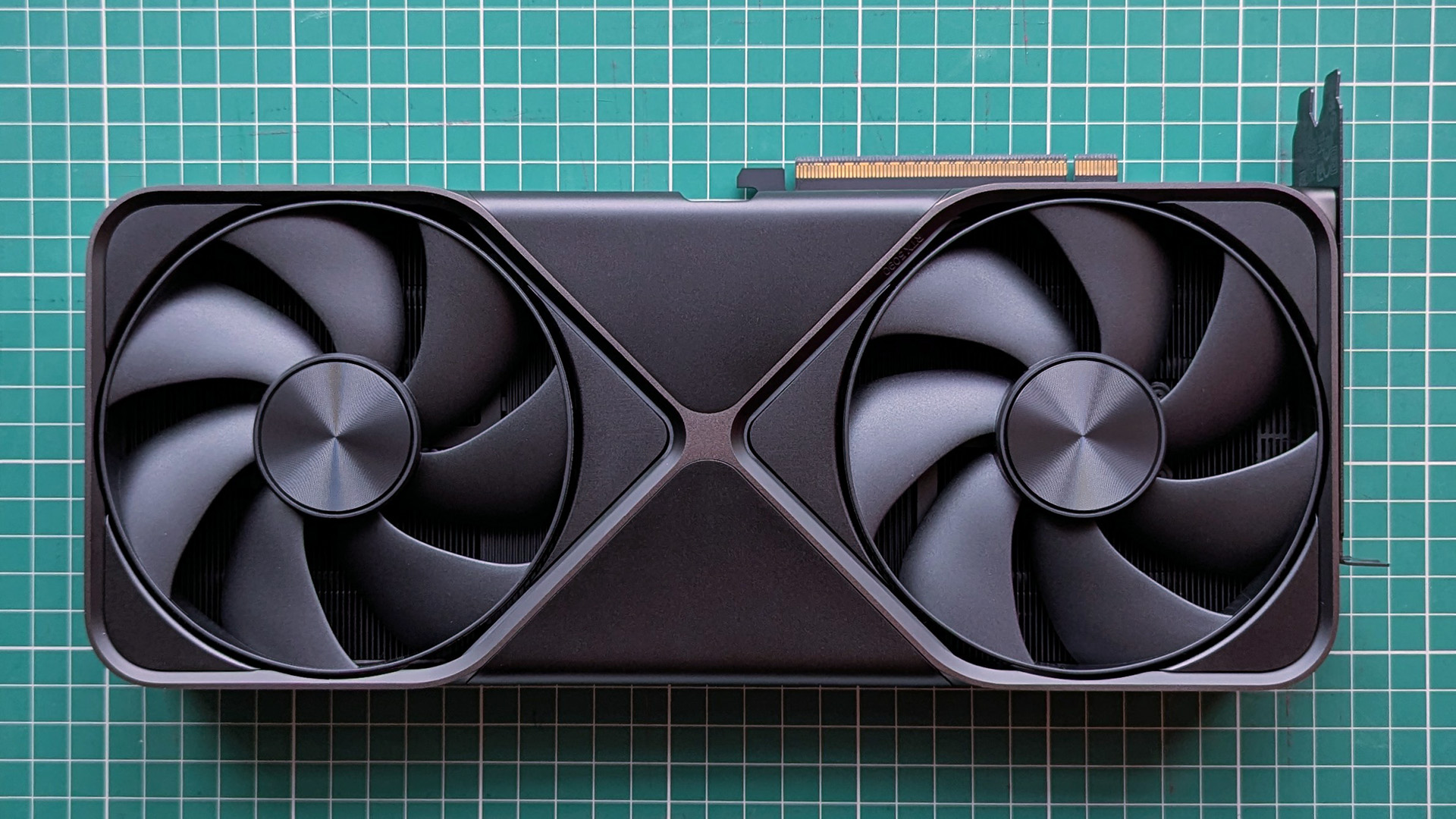

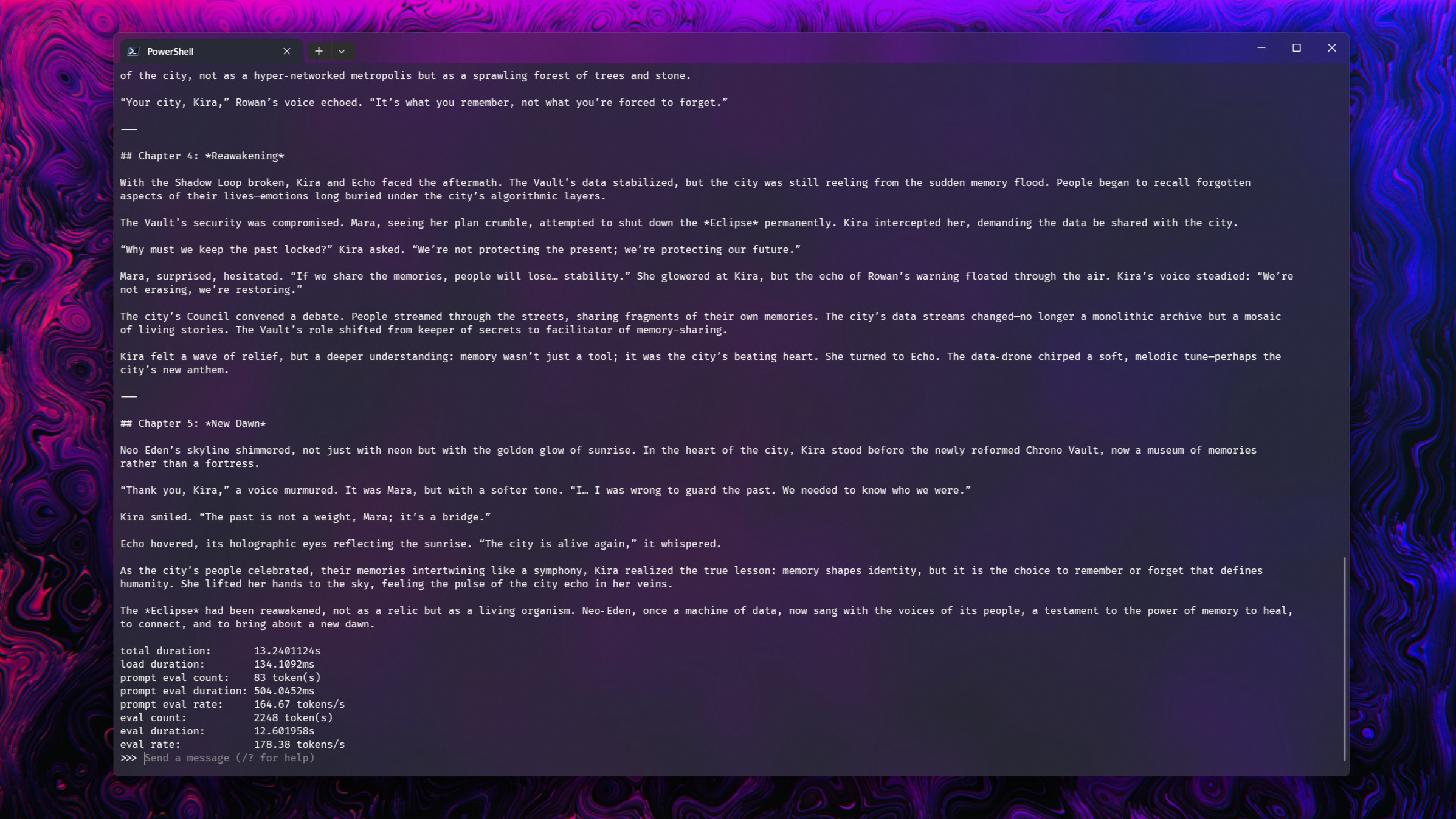

Важно отметить, что эти тесты довольно простые, поскольку я не фокусируюсь на точности результатов, а скорее демонстрирую схожий уровень производительности между ними. Четыре модели – deepseek-r1:14b, gpt-oss:20b, magistral:24b и gemma3:27b – были изучены, потому что все они плавно работают на видеокарте RTX 5090.

В каждом случае я задавал моделям два вопроса.

- Напишите историю из более чем пяти глав на выбранную вами тему и с выбранными вами персонажами. (История)

- Я хочу, чтобы вы создали клон игры Pong целиком на языке Python. Не используйте внешние ресурсы, и все графические элементы должны быть созданы внутри кода. Убедитесь, что импортированы все необходимые зависимости. (Код)

И вот результаты:

| Подсистема Windows для Linux | Windows 11 | |

| gpt-oss:20b | История: 176 токенов/сек. Код: 177 токенов/сек. | **История:** 176 токенов/сек **Код:** 181 токен/сек |

| магистральный:24b | История: 78 токенов/сек Код: 77 токенов/сек | История: 79 токенов/секКод: 73 токенов/сек |

| глубокий поиск-r1:14b | История: 98 токенов/сек. Код: 98 токенов/сек. | История: 101 токен/секКод: 102 токена/сек |

| gemma3:27b | История: 58 токенов/сек. Код: 57 токенов/сек. | История: 58 токенов/сек. Код: 58 токенов/сек. |

Есть некоторые незначительные колебания, но производительность практически идентична.

Простыми словами, когда работает подсистема Windows для Linux (WSL), она потребляет дополнительную оперативную память по сравнению с ситуацией, когда она не работает. Однако, поскольку ни одна из используемых моделей не потребляла больше видеопамяти, чем ей было выделено, это никак не повлияло на их производительность.

Для разработчиков, работающих в WSL, Ollama столь же мощный.

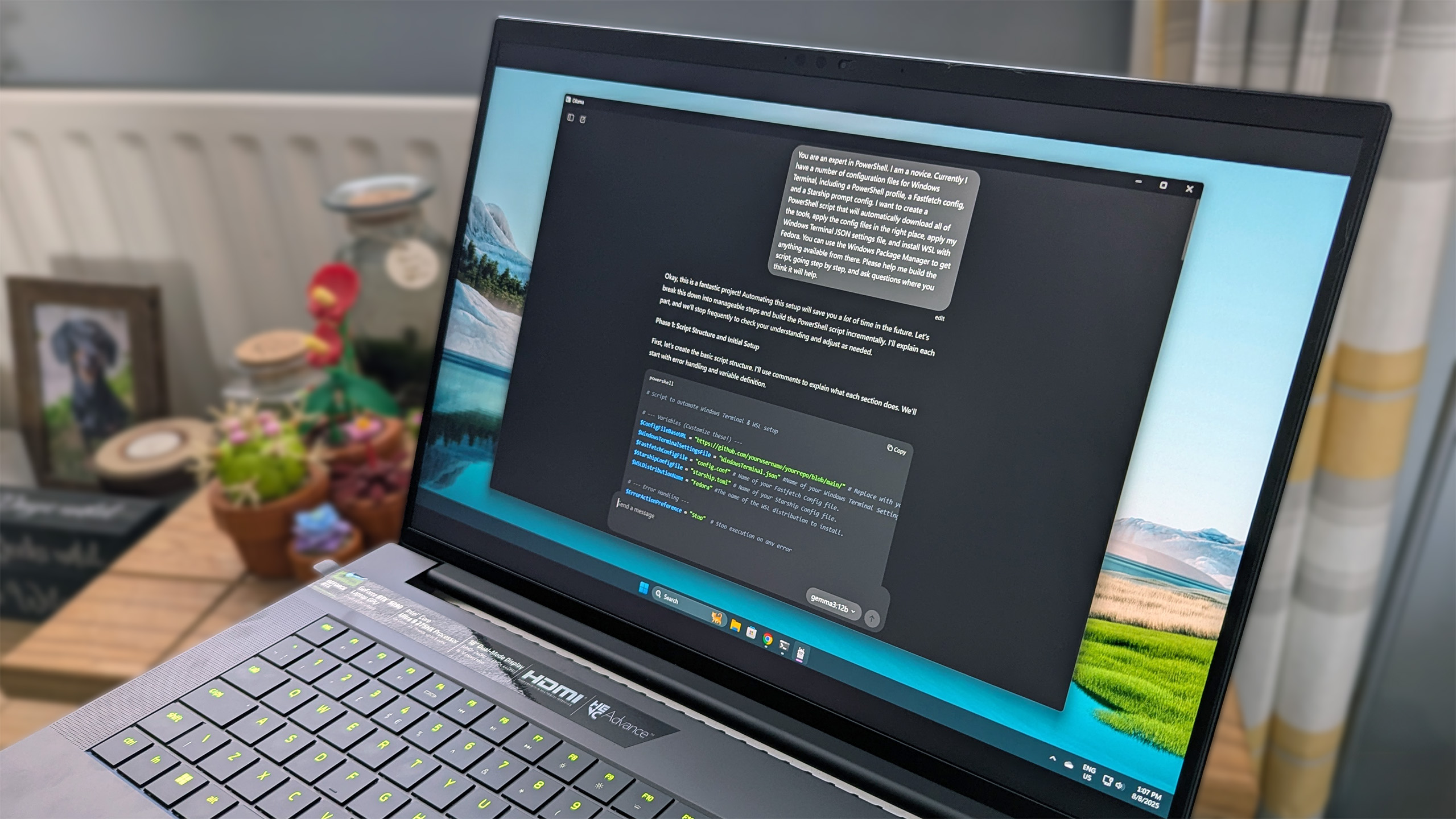

Обычный человек вроде меня (которому нравится работать с WSL) обычно не посчитает необходимым углубляться в использование Ollama так, как вы описали. На данный момент мое основное взаимодействие с Ollama носит образовательный характер, служа как инструментом для обучения, так и способом углубить понимание его внутренней работы.

Вы, конечно, можете использовать это в Windows 11, будь то напрямую в терминале или интегрированно с расширением для браузера Page Assist, с которым я экспериментировал в последнее время.

WSL выступает в качестве связующего звена между Windows и Linux для разработчиков. Используя Ollama, разработчики, полагающиеся на WSL, могут делать это без потери производительности.

Эта версия стремится сохранить исходный смысл, используя более простой язык и структуру предложений.

Сегодня по-прежнему удивительно, насколько плавно Linux может работать внутри Windows, позволяя полностью использовать графический процессор NVIDIA. Примечательно, что он функционирует так же гладко.

Смотрите также

- Vivo V17 Neo

- Российский рынок: Стагнация, риски и отдельные точки роста в феврале-марте (05.02.2026 19:32)

- Российский рынок: от сделок «Астры» до ставок ЦБ: что ждет инвесторов? (08.02.2026 14:32)

- Типы дисплеев. Какой монитор выбрать?

- Что такое кроп-фактор. Разница между DX и FX камерами.

- Лучшие смартфоны. Что купить в феврале 2026.

- Новые смартфоны. Что купить в феврале 2026.

- HMD Vibe ОБЗОР

- Калькулятор глубины резкости. Как рассчитать ГРИП.

- Неважно, на что вы фотографируете!

2025-09-03 18:19