За последние несколько месяцев я экспериментировал с инструментом Ollama, который предоставляет доступный способ для таких людей, как я, работать непосредственно с большими языковыми моделями на наших персональных компьютерах. Это довольно эффективно.

Пока крипто-инвесторы ловят иксы и ликвидации, мы тут скучно изучаем отчетность и ждем дивиденды. Если тебе близка эта скука, добро пожаловать.

Купить акции "голубых фишек"Использовать и настроить Ollama раньше не было особенно сложно, но это требовало нахождения в окне терминала. Однако теперь это уже не так.

Теперь Ollama предлагает элегантный графический пользовательский интерфейс (GUI), специально разработанный для Windows. Эта новая функция поставляется в виде официального приложения, которое устанавливается вместе с компонентами командной строки (CLI) во время настройки. Это изменение значительно снижает необходимость использования терминала для доступа к вашей LLM.

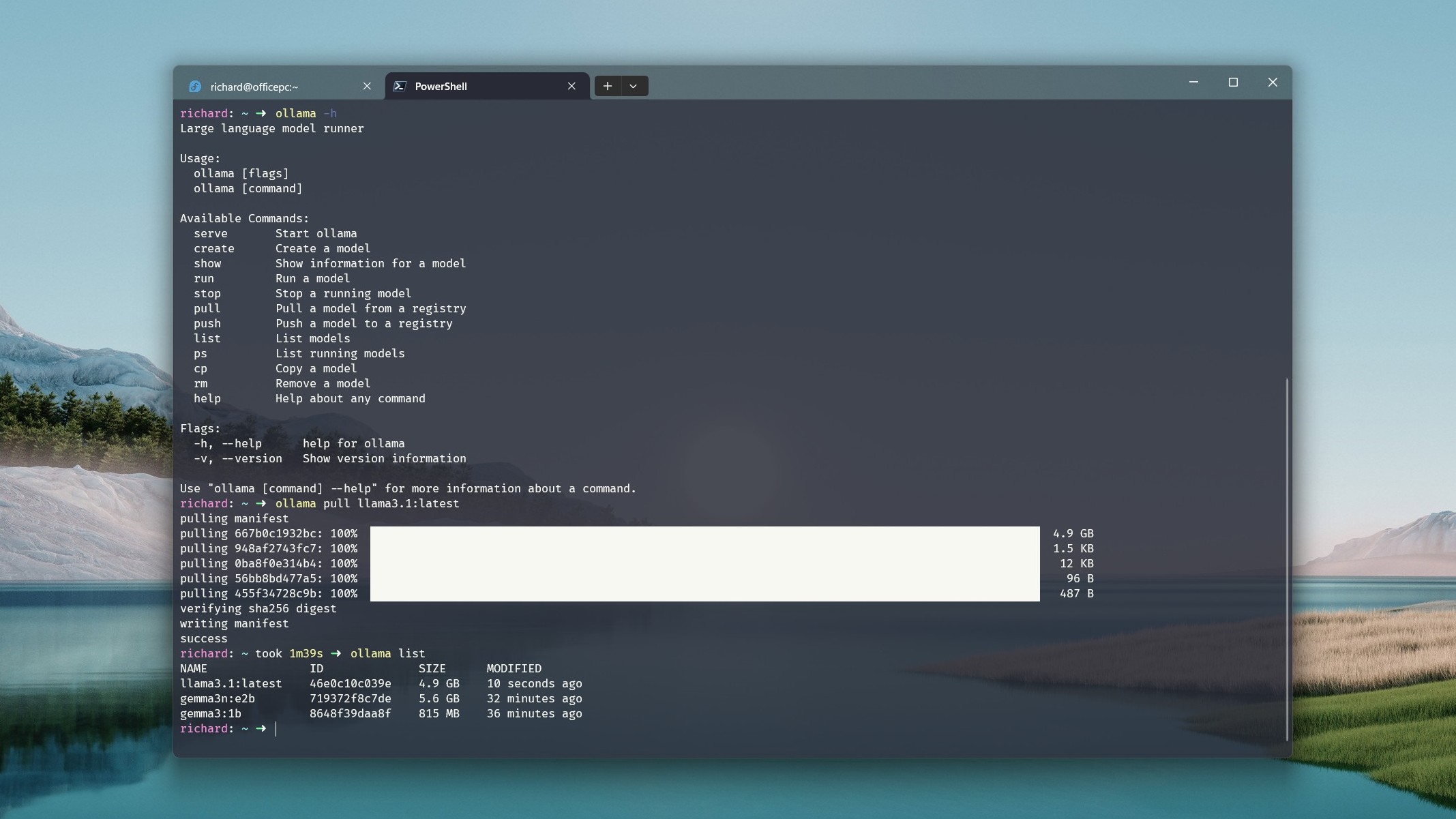

Если вам удобнее, вы можете скачать версию интерфейса командной строки (CLI) Олламы прямо из репозитория на Гитхабе.

Настройка обеих частей такая же простая: вам нужно только скачать Ollama с его веб-сайта, после чего запустить установочный файл. Программа автоматически запустится в фоновом режиме. Вы можете легко получить к ней доступ через системный трей или командную строку, либо начать ее напрямую из трея системы или меню Пуск.

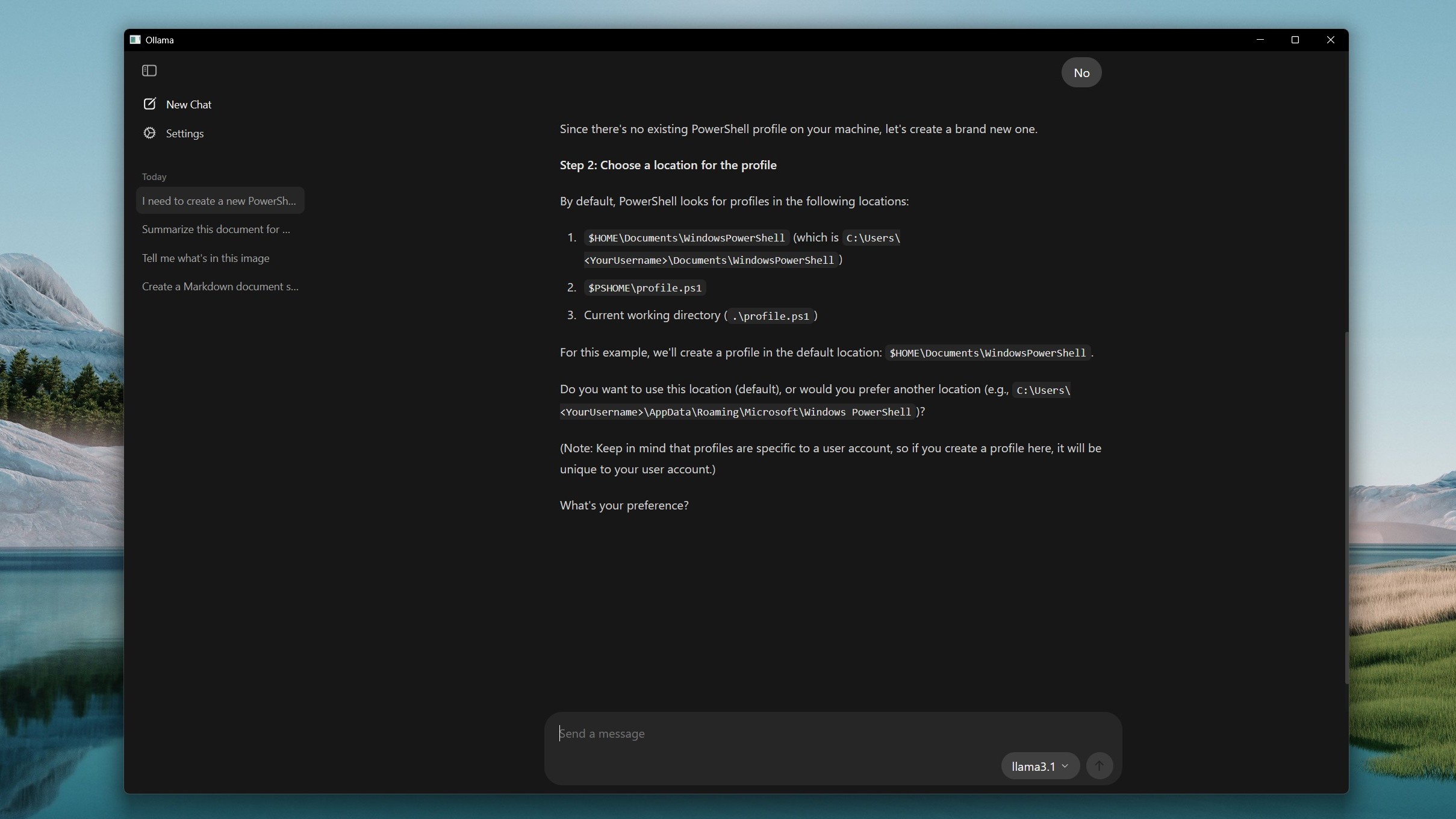

Использовать чат-бота с искусственным интеллектом, такого как Ollama, довольно просто, если вы уже работали с подобными сервисами раньше. Просто введите свое сообщение в поле ввода, и на основе выбранной вами модели, Ollama предоставит ответ.

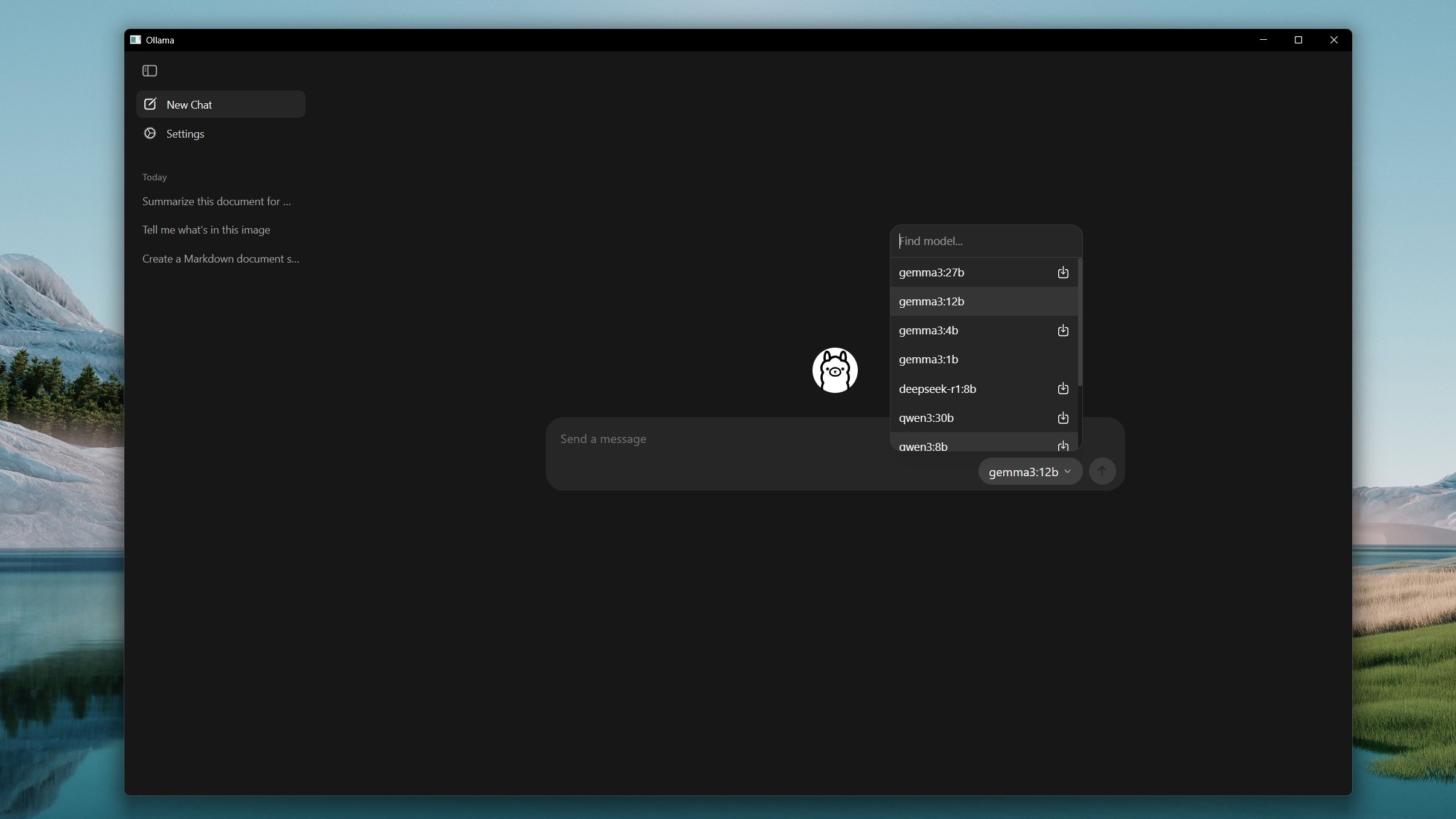

Похоже, что при нажатии на значок рядом с удалённой моделью она должна скачиваться и устанавливаться на ваше устройство, но на данный момент она, кажется, неактивна. Однако вы всё ещё можете находить модели, используя выпадающее меню для их поиска.

Вместо непосредственного извлечения моделей из терминала я обнаружил обходной путь, при котором сначала выбирается модель, а затем делается попытка отправить ей сообщение. Это действие запускает приложение Ollama для первоначальной загрузки модели. Конечно, доступ к моделям по-прежнему возможен через терминал, и они появятся в приложении позже.

Настройки могут быть простыми, но есть возможность регулировать размер области просмотра. Для больших файлов вы можете расширить область видимости с помощью ползунка, хотя это потребует дополнительной системной памяти, что имеет смысл из-за возросшего спроса.

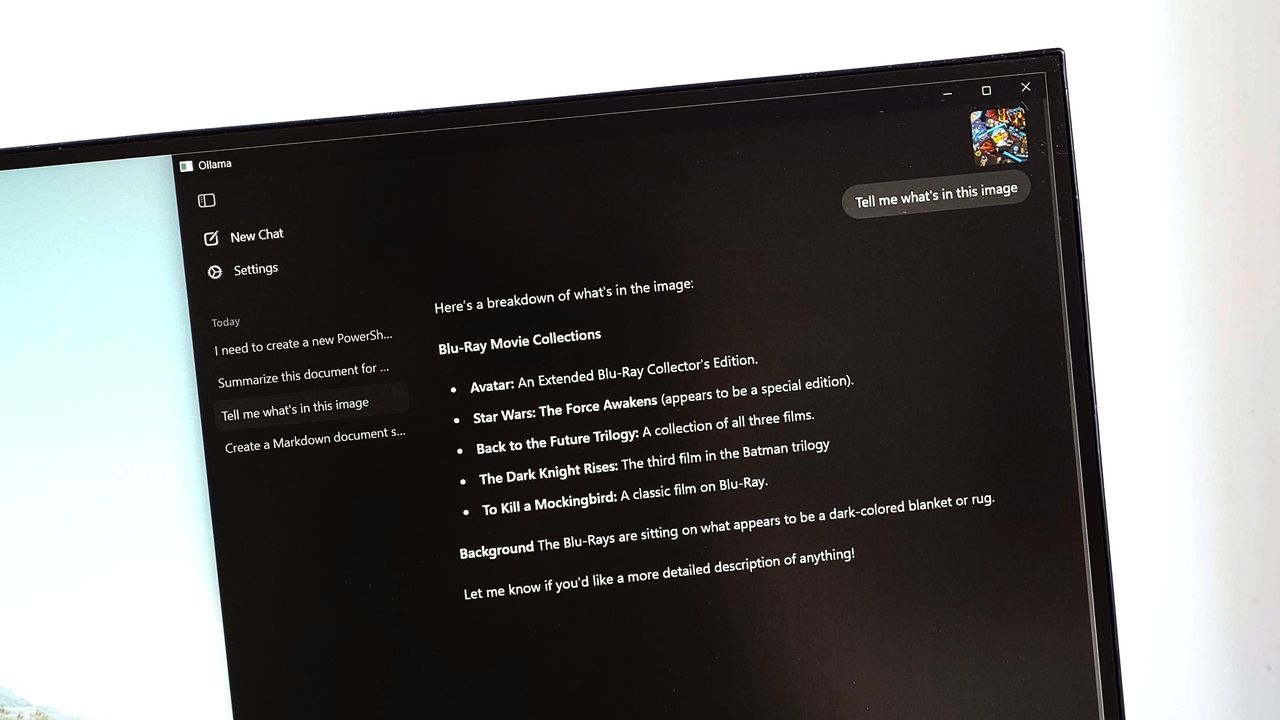

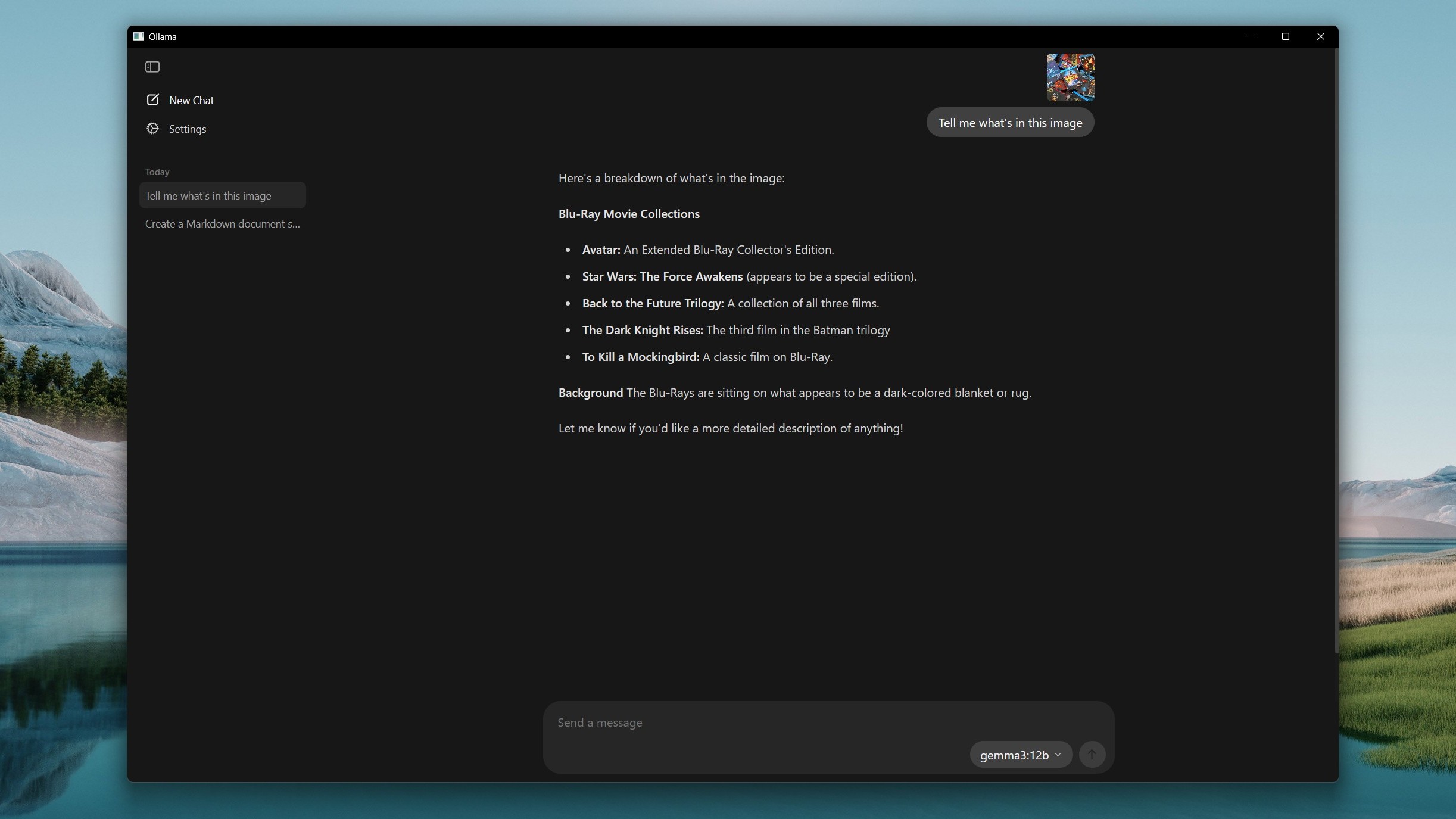

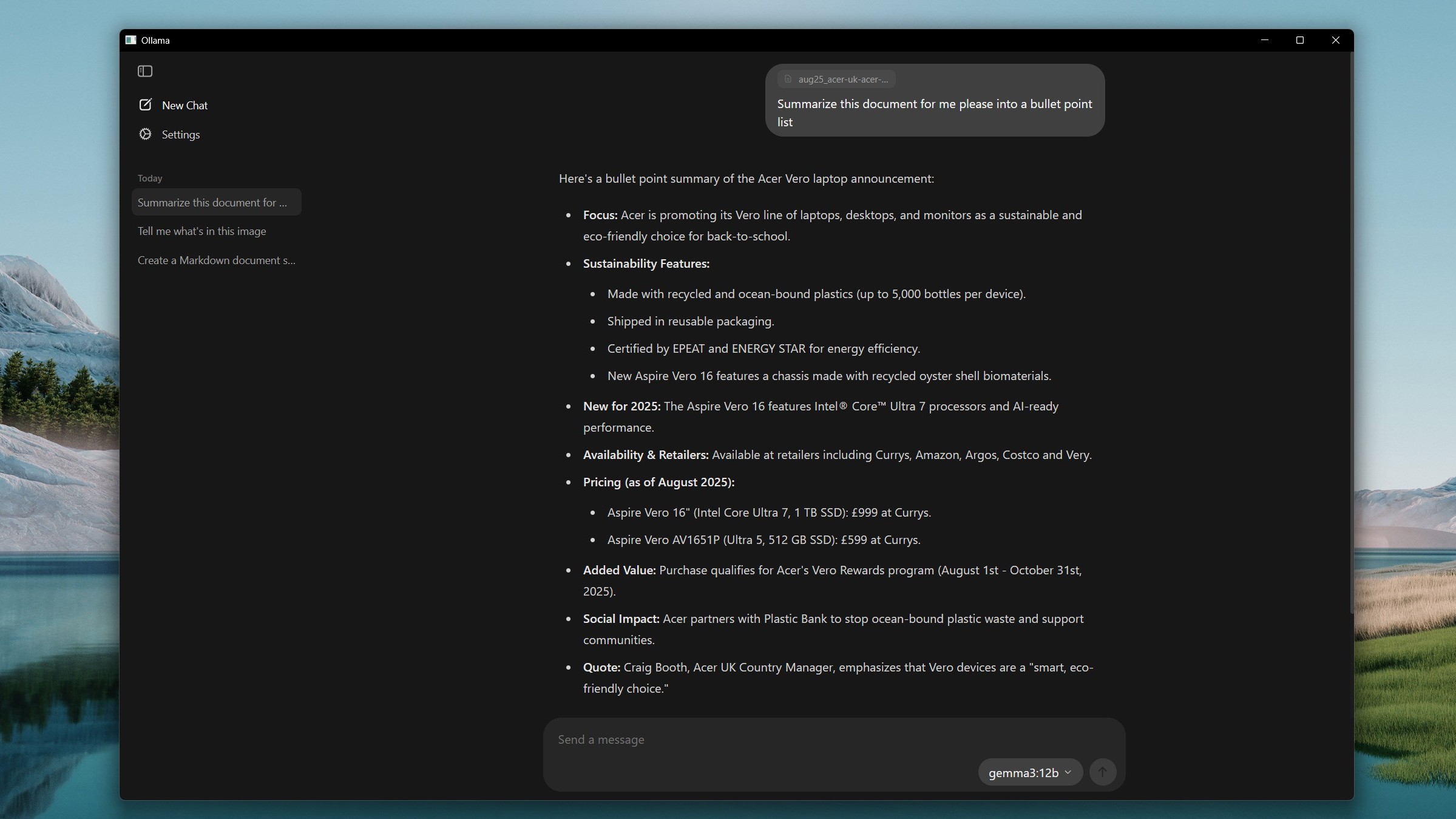

Последнее приложение Ollama предлагает несколько удобных функций, и сопровождающий его блог содержит пару видео, демонстрирующих эти возможности в реальном времени. Благодаря своим мультимодальным возможностям вы можете вставлять изображения в приложение и передавать их моделям, специализирующимся на их интерпретации, как например Gemma 3. В этой версии я постарался сохранить оригинальный смысл, делая текст более читабельным и естественным для английской речи или текста.

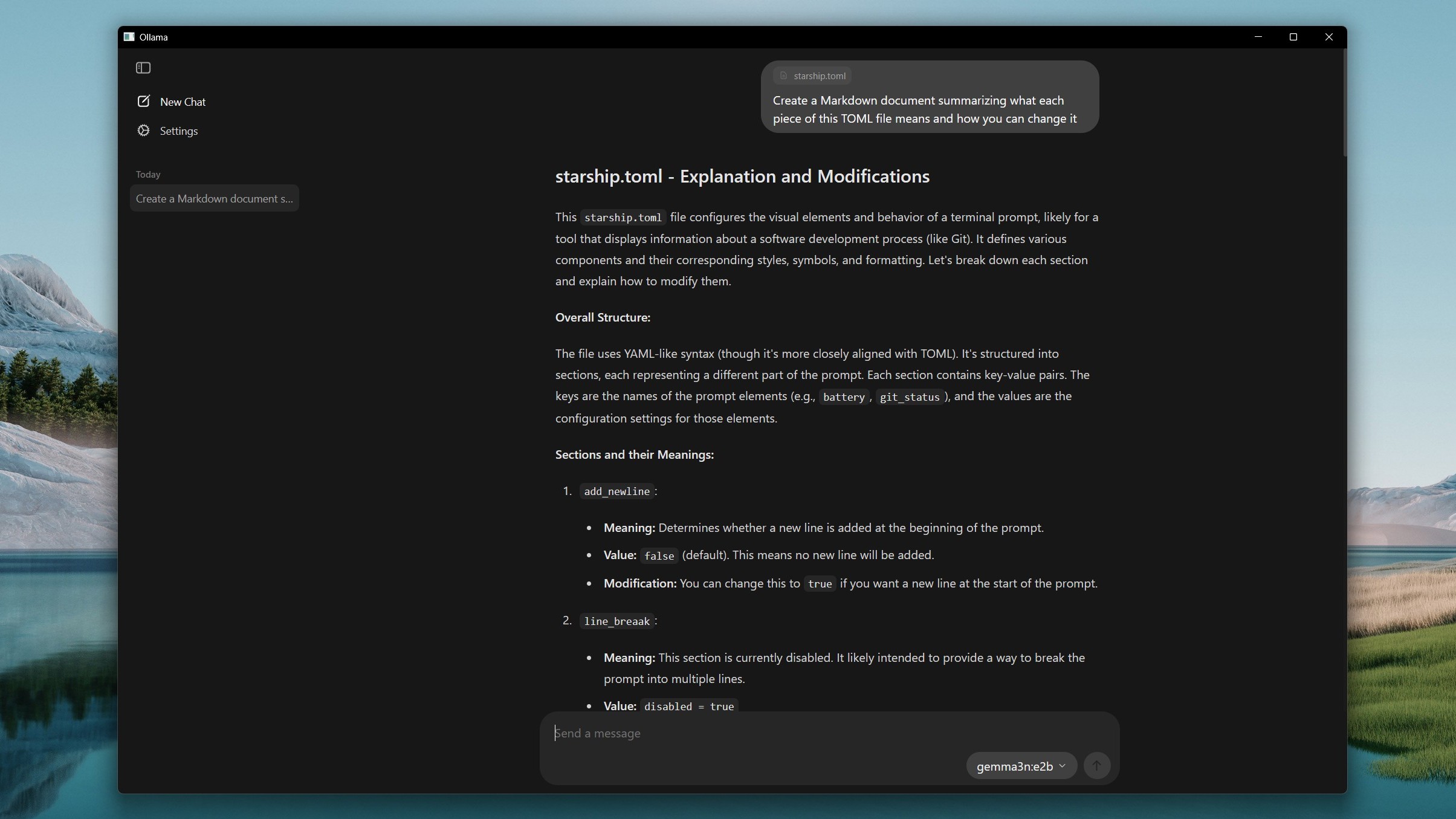

Приложение также способно расшифровывать ваши кодовые файлы, при условии, что вы поместите их внутрь. Например, если вы попросите приложение создать документ Markdown, подробно описывающий код и инструкции по его использованию, оно может сгенерировать следующее: «Вот объяснение предоставленного кода и руководство по его использованию: [Вставьте описание кода и инструкции по его использованию здесь] Чтобы запустить этот код, следуйте этим шагам: 1. [Первый шаг для запуска кода] 2. [Второй шаг для запуска кода] 3. [Третий шаг для запуска кода, если есть] Приятного кодирования!»

Использование функции перетаскивания Ollama для передачи файлов значительно удобнее, чем навигация через интерфейс командной строки (CLI). С этим методом вам не придется беспокоиться о поиске и запоминании расположений файлов.

На данный момент может быть полезно использовать интерфейс командной строки (CLI) для определенных функций в Ollama, поскольку некоторые функции, такие как отправка модели, создание моделей, список запущенных моделей, копирование и удаление, можно выполнять только через CLI, а не через приложение.

По моему мнению, это фантастический прогресс для повседневного использования. Имейте в виду, что те, кто до сих пор использовал локальные языковые модели, возможно, привыкли работать в окне терминала. Тем не менее, возможность и удовольствие работать с терминалом — это безусловно навык, который я всегда буду поддерживать.

Благодаря интеграции интуитивного графического пользовательского интерфейса (GUI) мы сделали инструмент более доступным для широкого круга пользователей. Ранее инструменты вроде Open WebUI успешно достигали этой цели, однако включение GUI в основной пакет упростило его использование.

Несмотря на это, важно отметить, что для использования этих моделей потребуется компьютер с достаточной вычислительной мощностью. На текущий момент Ollama не поддерживает Нейронные процессоры (NPU), делая систему в целом критически важной для их работы.

Для оптимальной производительности рассмотрите использование процессора Intel поколения 11 или процессора на базе архитектуры AMD Zen 4, поддерживающего AVX-512. Старайтесь использовать как минимум 16 ГБ оперативной памяти, но минимально рекомендуемая величина для моделей размером 7B от Ollama составляет 8 ГБ. Также доступны модели меньшего размера с меньшими требованиями к ресурсам.

Как исследователь могу заверить вас, что хотя графический процессор не является необходимым для всех задач, его наличие несомненно повышает производительность, особенно при работе с крупными моделями. Чем больше видеопамять (VRAM) у вашего GPU, тем эффективнее и плавнее будут выполняться эти трудоемкие задачи.

Использование локальной модели обучения языкам (LLM) может быть интересным опытом, особенно если ваш компьютер обладает соответствующими возможностями. Так как она не требует подключения к интернету, вы можете использовать её офлайн и не будете добавлять нагрузку на огромные серверы искусственного интеллекта.

Приложение Ollama не имеет встроенных возможностей веб-поиска, но если вам действительно нужна эта функция, можно найти обходные пути. Однако для поиска в интернете следует использовать что-то помимо приложения Ollama. Тем не менее, рекомендую скачать и попробовать его как возможного предпочитаемого AI чатбота.

Смотрите также

- Новые смартфоны. Что купить в феврале 2026.

- 10 лучших игровых ноутбуков. Что купить в феврале 2026.

- Что такое Bazzite и лучше ли она, чем Windows для PC-гейминга? Я установил этот набирающий популярность дистрибутив Linux, чтобы проверить это самостоятельно.

- 10 лучших OLED ноутбуков. Что купить в феврале 2026.

- Российский рынок акций: консолидация, риски и возможности в условиях неопределенности (11.02.2026 10:33)

- Калькулятор глубины резкости. Как рассчитать ГРИП.

- Российский рынок: от сделок «Астры» до ставок ЦБ: что ждет инвесторов? (08.02.2026 14:32)

- Лучшие смартфоны. Что купить в феврале 2026.

- МФК Займер акции прогноз. Цена ZAYM

- Типы дисплеев. Какой монитор выбрать?

2025-08-05 15:42