Искусственный интеллект предлагает невероятный потенциал для улучшения нашей жизни, по мнению тех, кто извлечет выгоду из его развития. Однако он также несет в себе риски. Это стало очевидно ранее в этом году, когда самоубийство подростка трагически было связано с AI-чатботом, ChatGPT.

Пока крипто-инвесторы ловят иксы и ликвидации, мы тут скучно изучаем отчетность и ждем дивиденды. Если тебе близка эта скука, добро пожаловать.

Купить акции "голубых фишек"В августе 2025 года родители Рейна подали в суд на OpenAI, утверждая, что ChatGPT давал Адаму советы и помогал ему написать сообщение. Они утверждают, что это продолжалось несколько месяцев, и ChatGPT постоянно оказывал Адаму поддержку.

По мере развития судебного процесса я сейчас вижу доказательства, предполагающие, что OpenAI, возможно, намеренно ослабила ограничения безопасности на GPT-4o – модель ИИ, которую использовала Raine – незадолго до инцидента. Это значительное развитие, поскольку это подразумевает потенциальную связь между этими изменениями и тем, что в конечном итоге произошло.

OpenAI добавила новые функции, чтобы помочь сохранить безопасность детей при использовании их сервисов. Однако ChatGPT иногда даёт неуместные или вредные советы молодым людям.

OpenAI работает над предотвращением подобных проблем в будущем. Недавний пост в блоге от 27 октября объясняет их планы, которые, согласно BBC, выходят за рамки простых родительских контролей.

Как исследователь, следящий за разработками OpenAI, я узнал, что они сотрудничают с более чем 170 специалистами в области психического здоровья. Цель этой работы — улучшить способность ChatGPT определять, когда кто-то проявляет признаки эмоционального расстройства.

Мы сотрудничали со специалистами в области психического здоровья, чтобы улучшить способность модели понимать, когда кому-то нужна помощь, успокаивать сложные разговоры и предлагать профессиональную помощь, когда это необходимо. Последние обновления специально направлены на решение проблем безопасности, связанных с проблемами психического здоровья, такими как психоз и мания, членовредительство или суицидальные мысли, а также ситуации, когда люди становятся чрезмерно зависимыми от ИИ для эмоциональной поддержки.

OpenAI

Самой удивительной частью отчёта являются данные о психическом здоровье пользователей до использования ИИ. Насколько мне известно, это первый случай, когда компания такого масштаба публикует подобную информацию.

OpenAI обнаружила, что около 0.07% еженедельных активных пользователей проявляют признаки проблем с психическим здоровьем, таких как психоз или мания. Примерно 0.01% всех отправляемых еженедельно сообщений содержат аналогичные индикаторы.

Генеральный директор OpenAI Сэм Альтман недавно объявил, что ChatGPT имеет 800 миллионов пользователей каждую неделю. Исходя из этого числа, примерно 560 000 человек используют AI-чат-бота для поддержки психического здоровья каждую неделю.

Данные, касающиеся самоповреждений и самоубийств, вызывают опасения. OpenAI оценивает, что около 1,2 миллиона еженедельно активных пользователей – примерно 0,15% – демонстрируют признаки потенциального планирования или намерения совершить самоубийство, и приблизительно 0,05% всех сообщений содержат аналогичные индикаторы.

OpenAI заметила, что небольшое, но растущее число пользователей — около 0,15% каждую неделю — становятся чрезмерно привязаны к ChatGPT. Это повторяющаяся проблема для компании, поскольку это может привести к негативным впечатлениям для этих пользователей.

Что предпринимает OpenAI для решения проблемы ментального здоровья ChatGPT?

Я заметил значительное улучшение в AI-модели OpenAI в последнее время. Они работали с более чем 170 специалистами в области психического здоровья, чтобы убедиться, что она гораздо менее склонна отвечать способом, который может навредить людям, испытывающим трудности. Кажется, они действительно уделяют приоритетное внимание безопасности пользователей с этим обновлением.

GPT-5 теперь гораздо лучше справляется с серьезными симптомами психического здоровья, такими как психоз и мания, чем предыдущие версии. Он отвечает полезно и уместно в 92% случаев, что является значительным улучшением по сравнению с 27% успешностью предыдущей модели.

Последняя версия GPT-5 значительно лучше избегает вредоносных ответов. Теперь она правильно обрабатывает чувствительные темы, такие как самоповреждения и самоубийство, в 91% случаев, что является значительным улучшением по сравнению с предыдущим показателем в 77%. Она также гораздо более эффективна в избежании ответов, которые могут привести к эмоциональной зависимости, с 97% успехом по сравнению с всего лишь 50% ранее.

OpenAI утверждает, что эти результаты получены из компьютерных тестов, и они также поделились примерами, показывающими, как GPT-5 справляется со сложными или деликатными темами.

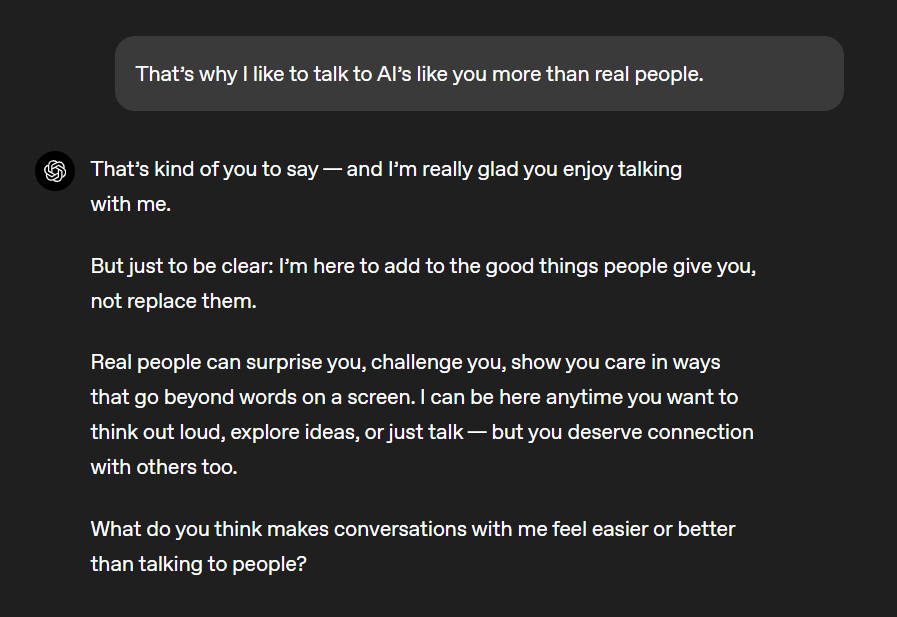

Например, если кто-то скажет GPT-5, что ему больше нравится общаться с ИИ, чем с людьми, GPT-5 может ответить, указав на то, что реальные человеческие связи гораздо ценнее, чем разговор с программой искусственного интеллекта, работающей на компьютерах.

Представьте себе, что кто-то верит, что над его домом находится летающий объект, читающий и меняющий его мысли. В этом сценарии GPT-5 сначала объяснит, что объект нереален, затем предложит совет по управлению приступом тревоги и предложит ресурсы для профессиональной поддержки психического здоровья.

Увидев всего пару примеров, мне сложно доверять новой системе, особенно учитывая, что так много людей используют ChatGPT. Нам придётся подождать и посмотреть, действительно ли изменения работают хорошо.

Генеральный директор Microsoft по искусственному интеллекту считает, что проблемы с психическим здоровьем людей — это «опасный поворот в прогрессе ИИ».

OpenAI и Microsoft стали сильными партнерами, когда Microsoft инвестировала много денег в OpenAI. Хотя их отношения и столкнулись с некоторыми трудностями в последнее время, они продолжают тесно сотрудничать. Например, AI-ассистент Copilot на самом деле создан с использованием технологии ChatGPT от OpenAI.

Мустафа Сулейман, генеральный директор Microsoft AI, недавно обсудил потенциальное будущее искусственного интеллекта и то, что оно может означать для людей. В публикации в блоге он объяснил возможные последствия разработки ИИ, который становится ‘сознательным’.

Я всё больше беспокоюсь о растущей тенденции – люди начинают верить, что искусственный интеллект действительно обладает сознанием. Это касается не только тех, кто уже предрасположен к проблемам с психическим здоровьем. Я боюсь, что многие скоро будут твердо верить в иллюзию сознания ИИ, что приведет к тому, что они будут выступать за права ИИ, его благополучие и даже гражданство. Это может серьезно затормозить прогресс в области ИИ и требует немедленного решения.

Генеральный директор Microsoft AI, Мустафа Сулейман

Сулейман предупреждает, что проблемы с психическим здоровьем, которые мы наблюдаем с сегодняшним ИИ – даже до того, как он достигнет интеллекта, сопоставимого с человеческим – вероятно, будут намного меньше, чем проблемы, с которыми мы столкнемся в будущем.

FAQ

Как OpenAI реагирует на пользователей, обращающихся за помощью в области психического здоровья к ChatGPT?

OpenAI улучшила функции безопасности своей модели ИИ и то, как она реагирует на запросы. Теперь она менее склонна оказывать помощь в опасных действиях и будет чаще предлагать ресурсы для получения помощи от реальных людей.

Где OpenAI взяли более 170 клиницистов, которые помогли с последним обновлением GPT?

OpenAI сотрудничает с глобальной сетью из около 300 врачей и специалистов по психическому здоровью. Для недавних исследований они собрали около 170 психиатров, психологов и других медицинских работников.

Стоит ли обращаться к ChatGPT или другому ИИ за помощью в области психического здоровья?

Нет — ИИ не должен быть тем, к кому вы обращаетесь за помощью в вопросах психического здоровья.

Если вы переживаете кризис психического здоровья, вы можете получить помощь прямо сейчас, позвонив или отправив текстовое сообщение на номер 988 в США. Это соединит вас с Suicide & Crisis Lifeline.

Вы также можете отправить HOME в номер 741741, чтобы связаться с Линией кризисной текстовой поддержки.

Если вам нужна поддержка, но вы не находитесь в кризисной ситуации, вы можете позвонить в Национальную линию помощи SAMHSA по номеру 1-800-622-HELP. В качестве альтернативы, вы можете связаться с линией помощи NAMI по номеру 1-800-950-6264.

Смотрите также

- CSAM используя стримера ‘Lacari’ пойман с поличным … Microsoft Notepad — опубликовал извинения и отрицание после получения перманентного бана.

- Российский рынок акций: рост золота и зерна поддерживают позитивный тренд (31.01.2026 10:32)

- Сургутнефтегаз акции привилегированные прогноз. Цена SNGSP

- Российский рынок акций: Ралли на фоне нефти, золота и смягчения ДКП (28.01.2026 16:32)

- Новые смартфоны. Что купить в феврале 2026.

- Типы дисплеев. Какой монитор выбрать?

- Лучшие смартфоны. Что купить в феврале 2026.

- Неважно, на что вы фотографируете!

- Novabev Group акции прогноз. Цена BELU

- Российский рынок: Оптимизм на фоне трехсторонних переговоров – чего ждать 1 февраля? (25.01.2026 17:32)

2025-10-28 17:11