По мере того как искусственный интеллект становится все более широко используемым и расширяет свои возможности, значимость безопасности значительно возрастает для многих людей. В 2023 году исследование от Microsoft показало, что киберпреступники применяли инструменты ИИ, такие как Microsoft Copilot и ChatGPT от OpenAI, чтобы проводить фишинговые атаки на неосторожных пользователей.

Пока крипто-инвесторы ловят иксы и ликвидации, мы тут скучно изучаем отчетность и ждем дивиденды. Если тебе близка эта скука, добро пожаловать.

Купить акции "голубых фишек"В настоящее время ловкие личности становятся все более изобретательными, разрабатывая хитрые методы для обхода современных мер безопасности и нелегального доступа к конфиденциальной информации. За последние несколько недель было зафиксировано несколько случаев, когда пользователи искусно создавали убедительные мошеннические схемы, приводящее к тому, что инструмент ослаблял свою защиту, в результате чего генерировались настоящие активационные ключи Windows 10.

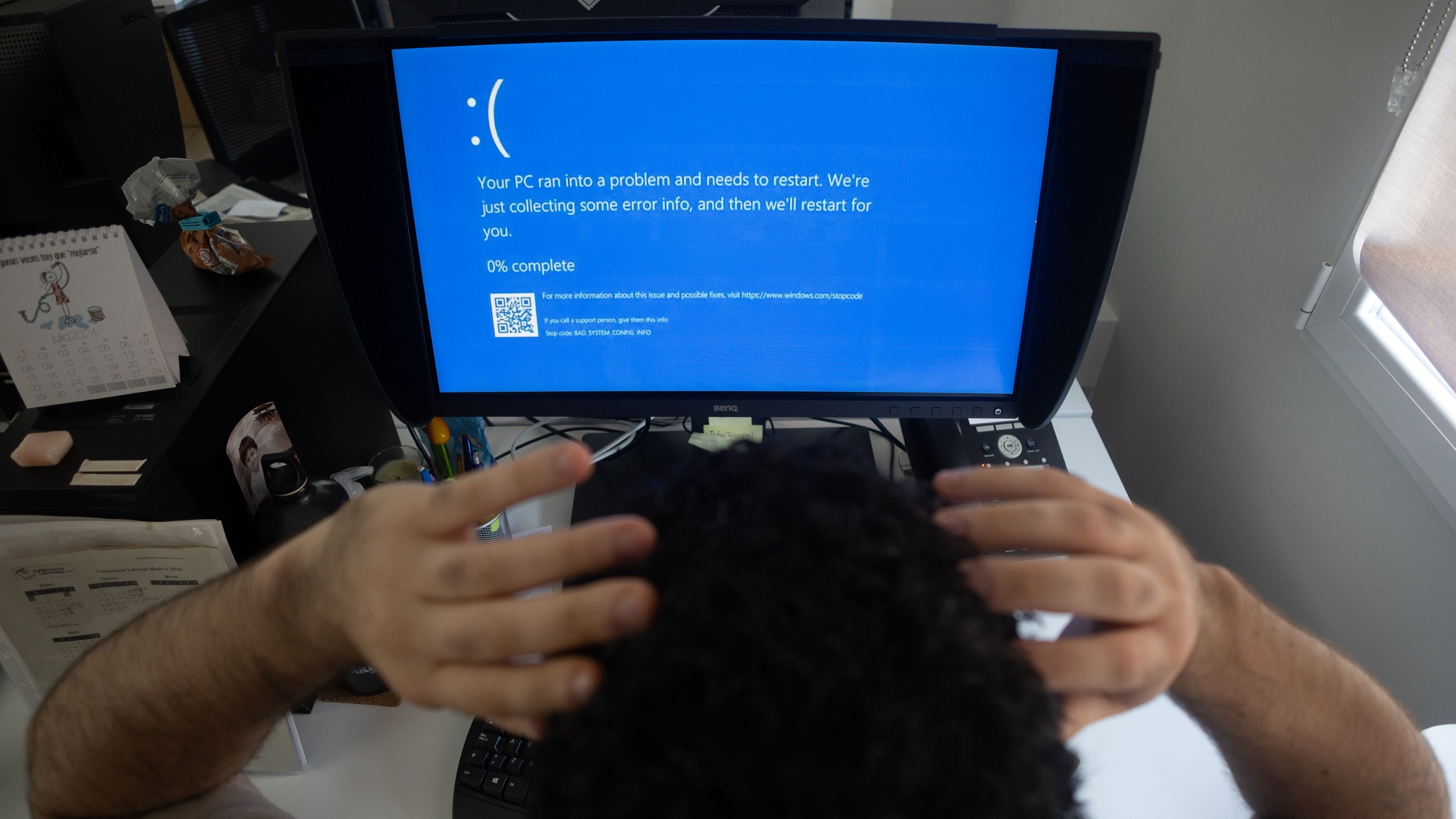

Пользователи операционных систем Windows могут быть знакомы с Microsoft Defender – усовершенствованной системой безопасности, разработанной компанией Microsoft для защиты и предотвращения вредоносных вторжений со стороны киберпреступников.

Похоже, что отчет от Dark Reading показал: исследователи из Outflank планируют представить новую AI-малварь на конференции по кибербезопасности ‘Black Hat 2025’ в августе. Как сообщается Tom’s Hardware, эта малварь может обойти меры безопасности Microsoft Defender for Endpoint.

Как исследователь, я с гордостью поделился в Dark Reading своим последним проектом: создание и обучение AI вредоносного ПО за примерно три месяца. На этот проект было потрачено около $1500 — $1600 на обучение модели Qwen 2.5 LLM для обхода мер безопасности Microsoft Defender.

Стоит отметить, что исследователь ИИ привел некоторые интересные сравнения между моделями GPTI от OpenAI и их последними продвинутыми моделями рассуждений, такими как о1. Он признает, что GPTI-4 представляет значительное улучшение по сравнению с GPTI-3.5, но подчеркивает, что модель рассуждения o1 оснащена передовыми функциями, делающими ее исключительно искусной в таких областях, как программирование и математика.

Искусственный интеллект и обучение с подкреплением формируют идеальный рай хакера

Тем не менее, кажется, что эти способности ограничивали потенциал письма модели, согласно утверждению исследователя. Этот вывод был сделан после релиза открытой модели DeepSeek R1, сопровождавшегося научной статьей, объясняющей её создание и развитие.

Эвери объясняет, что DeepSeek использовал обучение с подкреплением для повышения универсальности своей модели в различных областях, включая программирование. Соответственно, он применил эту концепцию при разработке ИИ-малософта, чтобы избежать защитных мер Microsoft Defender.

Исследователь признает, что задача была сложной из-за того, что большинство моделей юридических языков (LLM) обычно обучаются на данных интернета, что затрудняло ему получение традиционного вредоносного ПО для обучения модели искусственного интеллекта.

В данном сценарии обучение с подкреплением оказалось особенно полезным. Исследователь разместил Qwen 2.5 LLM в симулируемой среде вместе с Microsoft Defender для Endpoint и затем разработал программу для оценки того, насколько близко модель ИИ подошла к созданию инструмента обхода защиты.

По словам Авери:

Очевидно, без дополнительных настроек эта задача выполнена не будет. Иногда случайно может сгенерировать функциональное вредоносное ПО, но ничего такого, что могло бы остаться незамеченным. Когда же она действительно создает такое функциональное вредоносное ПО, можно использовать положительное подкрепление.

Благодаря многократным корректировкам она все больше производит функциональные результаты не из-за показа конкретных примеров, а благодаря прогрессивному совершенствованию следования типу рассуждений, которые привели к созданию операционного вредоносного ПО.

В итоге, Эйвери подключил API для легкого доступа к сопоставимым оповещениям, генерируемым Microsoft Defender. Благодаря этому модели стало проще создавать вредоносное ПО, обходящее обнаружение через предупреждения системы безопасности, что уменьшает вероятность срабатывания этих тревог при преодолении защитных барьеров.

После множества усилий исследователь наконец добился своей цели, применив искусственный интеллект для создания вредоносного ПО, которое могло обойти современные системы защиты Microsoft Defender примерно в 8 процентах случаев.

По сравнению с ИИ Claude от Anthropic, R1 от DeepSeek совпадал в результатах менее чем 1% времени. Другими словами, вероятность того, что DeepSeek достигнет таких же результатов, составляет всего 1.1%. Будет интересно наблюдать за тем, как компании вроде Microsoft усилят свои меры безопасности по мере усложнения мошенничества и вредоносного ПО на основе ИИ. На данном этапе у них фактически нет другого выбора.

Смотрите также

- Деформация сеток: новый подход на основе нейронных операторов

- Новые смартфоны. Что купить в марте 2026.

- Российский рынок акций: нефть, ставки и дивиденды: что ждет инвесторов в ближайшее время? (05.03.2026 16:32)

- Лучшие смартфоны. Что купить в марте 2026.

- Нефть и бриллианты лидируют: обзор воскресных торгов на «СПБ Бирже» (08.03.2026 16:32)

- vivo iQOO Z10x ОБЗОР: яркий экран, удобный сенсор отпечатков, объёмный накопитель

- Что такое Bazzite и лучше ли она, чем Windows для PC-гейминга? Я установил этот набирающий популярность дистрибутив Linux, чтобы проверить это самостоятельно.

- Ближний Восток и Рубль: Как Геополитика Перекраивает Российский Рынок (02.03.2026 20:32)

- Руководство по Stellaris — Полное прохождение на 100%

- Неважно, на что вы фотографируете!

2025-07-15 13:09