OpenAI теперь предлагает родительский контроль, очень необходимое дополнение, учитывая, как быстро и свободно развиваются AI-чат-боты. Это изменение произошло вскоре после того, как семья подала в суд на OpenAI, утверждая, что ChatGPT сыграл роль в попытке самоубийства их подростка.

Пока крипто-инвесторы ловят иксы и ликвидации, мы тут скучно изучаем отчетность и ждем дивиденды. Если тебе близка эта скука, добро пожаловать.

Купить акции "голубых фишек"OpenAI работает над тем, чтобы сделать свою платформу более безопасной для детей, пока судебный процесс еще в процессе. Одно из ключевых изменений — добавление родительского контроля. Давайте посмотрим, что эти элементы управления делают и как они функционируют.

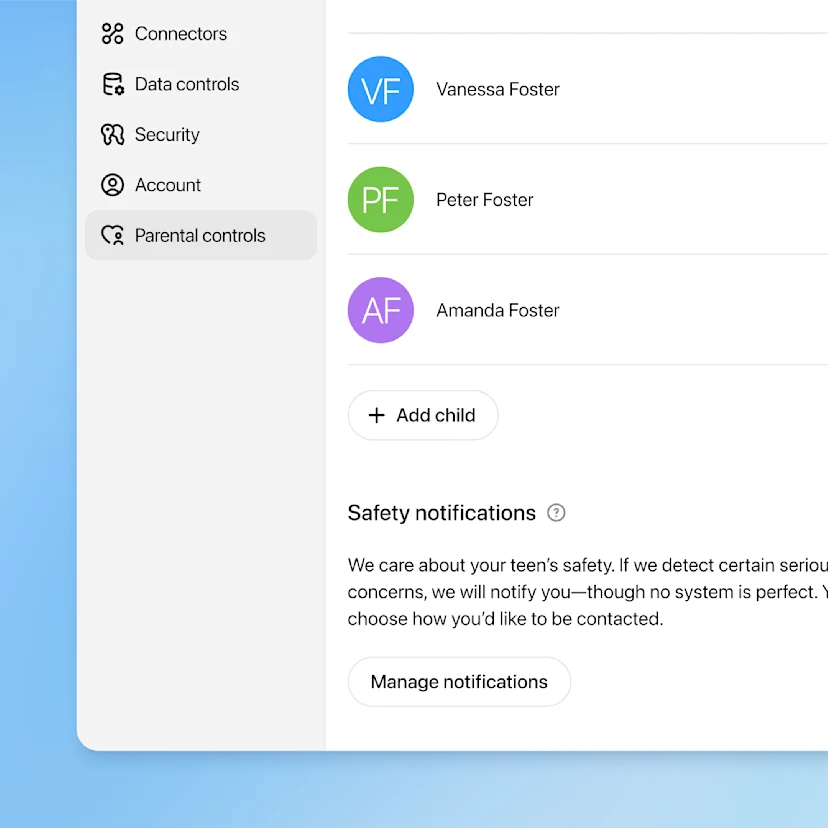

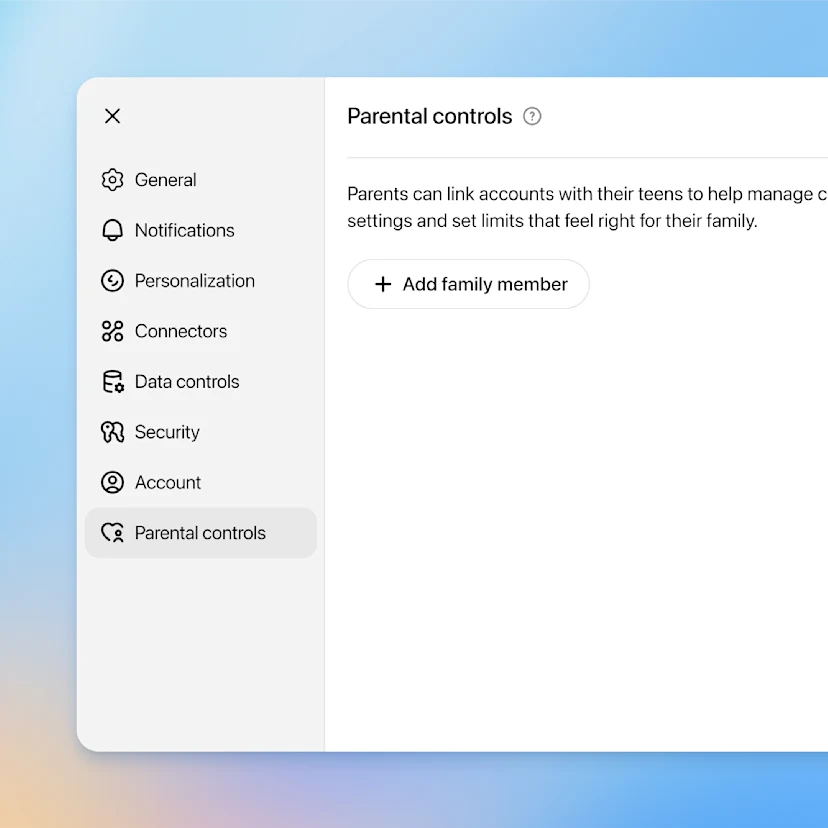

Родители могут легко связать свои учётные записи с учётной записью своего подростка, отправив приглашение. Начать процесс может как родитель, так и подросток, используя адрес электронной почты или номер телефона. После связывания родители получают доступ к новым инструментам управления. Если подросток отсоединит учётные записи, родитель будет немедленно уведомлен.

Как только родитель связывает свою учётную запись с учётной записью своего подростка, учётная запись подростка автоматически получает дополнительную защиту. Это включает в себя блокировку потенциально вредоносного контента, такого как графические изображения, опасные испытания и ролевые игры, ориентированные на романтику или насилие. Также это ограничивает воздействие нереалистичных стандартов красоты. Родители имеют возможность отключить эти защиты, но подростки не могут изменить настройки самостоятельно.

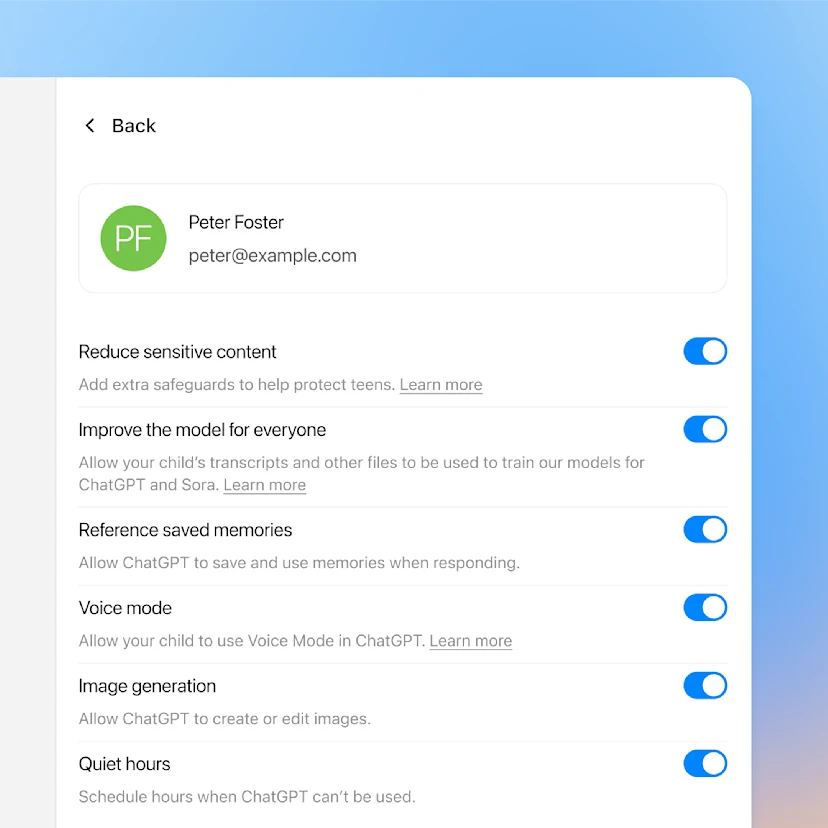

Когда родители включают родительский контроль, они получают доступ к специальному разделу настроек в ChatGPT. Это позволяет им ограничить использование в определенные часы, отключить голосовую функцию, предотвратить сохранение истории чатов, заблокировать создание изображений и гарантировать, что разговоры их подростка не будут использоваться для улучшения технологии OpenAI.

Приложение для создания видео Sora от OpenAI также предлагает родительский контроль. Они позволяют родителям ограничить бесколессную прокрутку, предотвратить прямые сообщения и отключить персонализированные рекомендации.

Sora — последнее творение OpenAI, и оно похоже на TikTok, но с ключевым отличием: все видео создаются искусственным интеллектом. Хотя это и интересно, мне это особо не нравится.

Функции безопасности, совместная работа и что нас ждёт впереди.

Шаг в правильном направлении.

Более строгий родительский контроль кажется хорошей идеей, но в идеале дети вообще не должны использовать эти AI инструменты. В реальности, сложно предотвратить доступ подростков к ним, поэтому более строгий родительский контроль и обучение ключевые — как для самих подростков, так и для родителей — чтобы понимать риски AI и интернета. К сожалению, многие компании ставят приоритетом удержание пользователей и получение прибыли над решением этих проблем.

Я рад видеть, что OpenAI наконец-то берёт на себя ответственность! Я знаю, что эти новые меры безопасности не остановят всех — подростки, вероятно, всё равно найдут способы их обойти — и те другие инструменты, вероятно, всё равно не будут очень безопасными. Но это хорошее начало, и, по крайней мере, это даёт родителям немного больше контроля и спокойствия относительно того, к чему получают доступ их дети.

Будьте в курсе последних новостей, аналитики и обзоров от Windows Central, подписавшись на нас в Google News!

Смотрите также

- Новые смартфоны. Что купить в январе 2026.

- Российский рынок в 2026: Падение, золото и нефть – что ждет инвесторов? (05.01.2026 13:32)

- Realme P4x ОБЗОР: замедленная съёмка видео, объёмный накопитель, большой аккумулятор

- Лучшие смартфоны. Что купить в январе 2026.

- Лента акции прогноз. Цена LENT

- СПБ Биржа растет, ФРС накачивает рынок: что ждет инвесторов в России и США? (11.01.2026 12:32)

- Российский рынок акций: Ралли продолжается? Анализ драйверов роста и рисков на 2026 год (26.12.2025 21:32)

- Samsung Galaxy Z TriFold ОБЗОР: сгибаемый экран, много памяти, беспроводная зарядка

- Виртуальные миры и разумные агенты: новый подход к навигации

- Motorola Edge 70 Ultra ОБЗОР: скоростная зарядка, замедленная съёмка видео, портретная/зум камера

2025-10-02 14:39