Генеративный ИИ значительно улучшился и теперь используется во многих областях, включая технологии, образование и здравоохранение. Он прошел долгий путь от своих ранних стадий, когда он часто был ненадежным и склонен к ошибкам.

Пока крипто-инвесторы ловят иксы и ликвидации, мы тут скучно изучаем отчетность и ждем дивиденды. Если тебе близка эта скука, добро пожаловать.

Купить акции "голубых фишек"Ведущие компании в области искусственного интеллекта, такие как Anthropic, OpenAI и Google, полагаются на информацию, которой люди делятся в интернете, чтобы обучать свои системы искусственного интеллекта, известные как большие языковые модели. Недавно в отчете указывалось, что они сталкиваются с проблемой: нехватка качественных данных препятствует их способности создавать еще более мощный ИИ.

Разработка искусственного интеллекта по-прежнему сталкивается со старыми проблемами. Недавнее исследование Корнеллского университета показало, что большие языковые модели (LLMs) могут испытывать снижение производительности – по сути, ‘гниль мозга’ – если они обучаются на большом количестве некачественных данных из интернета. Это говорит о том, что качество данных, используемых для обучения ИИ, имеет решающее значение для поддержания его возможностей.

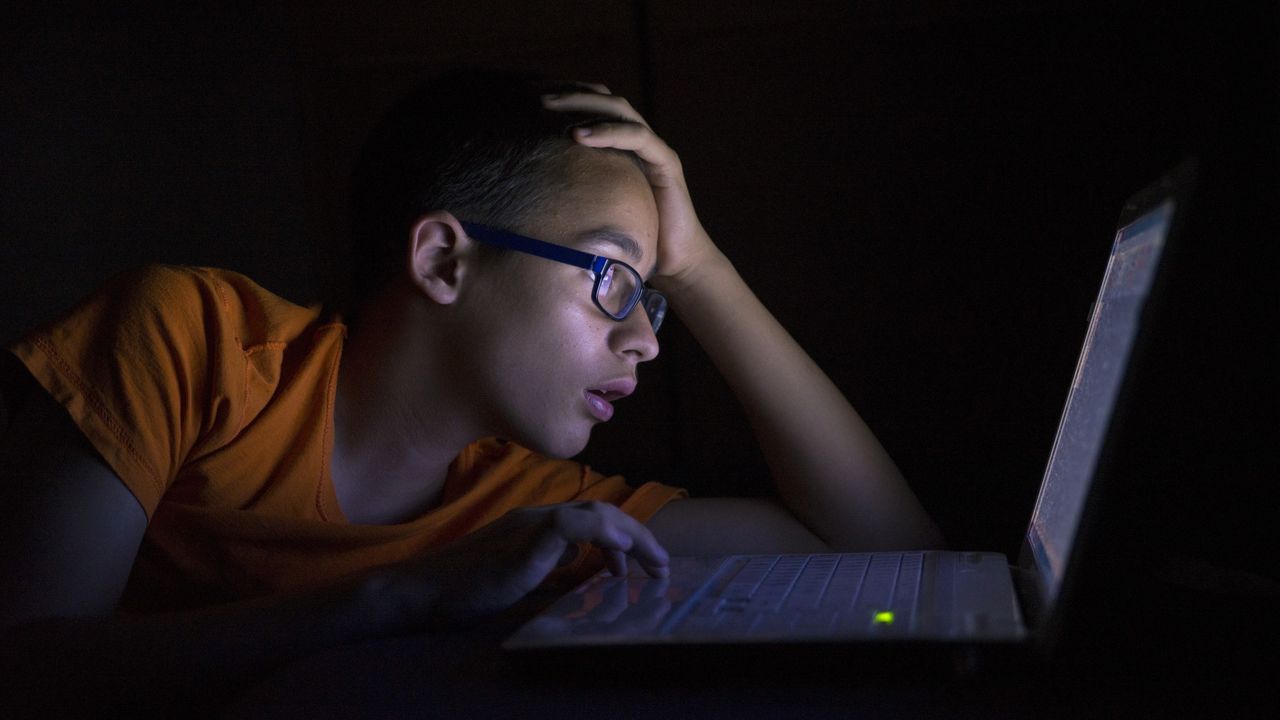

Фраза ‘internet brain rot‘ описывает то, что происходит, когда люди проводят много времени, глядя на глупые или неважные вещи в сети. Исследования показывают, что это может фактически повредить нашу способность ясно мыслить, решать проблемы и концентрироваться. То же самое, по-видимому, верно и для систем искусственного интеллекта.

Исследователи оценили нежелательный онлайн-контент, используя два различных метода. Во-первых, они изучили, сколько внимания получали короткие, популярные публикации. Во-вторых, они оценили качество самого контента, уделяя особое внимание публикациям, которые были плохо написаны и сильно полагались на сенсационные заголовки для привлечения кликов.

Итак, исследователи фактически создали множество различных наборов данных – некоторые с преимущественно хорошей информацией, а другие с большим количеством мусора. Они сделали это, чтобы действительно увидеть, как все эти низкокачественные данные влияют на большие языковые модели, такие как Llama 3 и Qwen 2.5. Как фанат, мне действительно интересно узнать, что они обнаружили – важно знать, как эти модели обрабатывают плохие данные!

Это исследование было направлено на то, чтобы выяснить, как зависимость от растущего объема некачественного онлайн-контента – такого как краткие, трендовые или автоматически созданные публикации – влияет на системы искусственного интеллекта.

Исследование также показало значительное падение точности ИИ при обучении исключительно на некачественном контенте, снизившись с 74.9% до 57.2%. Способность ИИ понимать длинные текстовые фрагменты также значительно снизилась, уменьшившись с 84.4% до 52.3%. Исследователи обнаружили, что продолжение обучения на этих низкокачественных данных еще больше ослабит навыки мышления и понимания ИИ – закономерность, которую они назвали «эффектом доза-ответ», что означает, что чем больше плохих данных, тем хуже производительность.

Исследование показало, что предоставление моделям большого количества некачественной информации приводило к снижению их этической последовательности, что приводило к изменению их ответов с течением времени. Это делало их более склонными к предоставлению неверных ответов и в целом менее надёжными.

Когда модели получали неточную информацию, это нарушало их логическое мышление. Вместо того, чтобы тщательно прорабатывать проблемы, они склонны были делать поспешные выводы и выдавать поверхностные ответы.

Теория мёртвого интернета превращается в реальность

В последнее время известные технологические лидеры, такие как Алексис Оханян из Reddit и Сэм Альтман из OpenAI, обсуждают идею о том, что интернет становится менее человечным и более заполненным контентом, сгенерированным ИИ, – концепцию, известную как ‘теория мёртвого интернета’. Эта дискуссия набирает обороты по мере того, как ИИ становится всё более способным действовать независимо.

Стив Оханян недавно заявил, что большая часть интернета сейчас ощущается сломанной из-за растущего присутствия ботов и базового ИИ. Но он верит, что появится новый вид социальных сетей, где вы можете быть уверены, что взаимодействуете с реальными людьми.

Это действительно подчёркивает, насколько безжизненной кажется большая часть интернета в наши дни — эта идея, что интернет ‘умирает’, понимаете? Большая часть того, что мы видим, — это либо автоматизированные боты, что-то, созданное базовым AI, или просто некачественный контент, особенно на платформах вроде LinkedIn. Видеть реальную, живую активность — таких как живые зрители и действительно новый контент — невероятно важно для поддержания вовлечённости людей.

Соучредитель Reddit, Alexis Ohanian

Генеральный директор OpenAI, Сэм Альтман, похоже, согласен с мнением, что интернет становится менее аутентичным, предполагая, что мы уже видим доказательства этого. Он также заявил, что большое количество аккаунтов в X (ранее Twitter), вероятно, управляются языковыми моделями ИИ.

Недавнее исследование Amazon Web Services (AWS) показало, что более половины (57%) онлайн-контента создаётся или изменяется искусственным интеллектом. Это вызывает проблемы с точностью и полезностью результатов поиска.

Джек Дорси, сооснователь и бывший руководитель Twitter, предупредил, что будет все сложнее отличить правду от лжи в интернете. Он объяснил это прогрессом в создании изображений и видео, включая дипфейки, и посоветовал людям быть более осторожными и проверять информацию самостоятельно, чтобы убедиться в ее подлинности.

Смотрите также

- CSAM используя стримера ‘Lacari’ пойман с поличным … Microsoft Notepad — опубликовал извинения и отрицание после получения перманентного бана.

- Российский рынок акций: рост золота и зерна поддерживают позитивный тренд (31.01.2026 10:32)

- Российский рынок акций: Ралли на фоне нефти, золота и смягчения ДКП (28.01.2026 16:32)

- Сургутнефтегаз акции привилегированные прогноз. Цена SNGSP

- Неважно, на что вы фотографируете!

- Лучшие смартфоны. Что купить в феврале 2026.

- Новые смартфоны. Что купить в феврале 2026.

- Novabev Group акции прогноз. Цена BELU

- Типы дисплеев. Какой монитор выбрать?

- Калькулятор глубины резкости. Как рассчитать ГРИП.

2025-10-22 14:10