Автор: Денис Аветисян

Исследователи разработали подход, позволяющий предсказывать, насколько хорошо визуальный контент запоминается, используя данные из онлайн-форумов, где люди ищут забытые слова.

Пока крипто-инвесторы ловят иксы и ликвидации, мы тут скучно изучаем отчетность и ждем дивиденды. Если тебе близка эта скука, добро пожаловать.

Купить акции "голубых фишек"

В статье представлена масштабная база данных ToT2MeM, созданная на основе запросов пользователей, испытывающих феномен ‘на кончике языка’, и демонстрируется ее эффективность в задачах генерации описаний и мультимодального поиска.

Несмотря на значительный прогресс в изучении визуальной памяти, создание масштабных и разнообразных датасетов для моделирования запоминаемости контента остается сложной задачей. В данной работе, посвященной ‘Unsupervised Memorability Modeling from Tip-of-the-Tongue Retrieval Queries’, представлен новый подход, использующий запросы из онлайн-форумов, посвященных состоянию «на кончике языка», для построения крупномасштабного неразмеченного датасета. Полученные результаты демонстрируют, что предложенный датасет эффективно используется для задач генерации описаний и мультимодального поиска, превосходя существующие модели, включая GPT-4o. Не откроет ли это новые горизонты для более глубокого понимания механизмов визуальной памяти и разработки интеллектуальных систем взаимодействия с контентом?

Разбирая Память: Основы Визуального Воспоминания

Понимание механизмов человеческой памяти является фундаментальным для создания по-настоящему интеллектуальных систем. Неслучайно, даже в повседневном опыте наблюдается хрупкость доступа к воспоминаниям — так называемое “на кончике языка”, когда информация кажется доступной, но не может быть мгновенно извлечена. Этот феномен подчеркивает, что память — это не просто хранилище данных, а сложный процесс кодирования, сохранения и воспроизведения информации, подверженный ошибкам и искажениям. Исследование этих процессов позволяет глубже понять принципы работы человеческого мозга и разработать более эффективные алгоритмы машинного обучения, способные к гибкому и надежному извлечению информации из больших объемов данных, подобно тому, как это делает человек.

Визуальная запоминаемость играет ключевую роль в эффективности кодирования и последующего извлечения изображений из памяти, оказывая значительное влияние на самые разные сферы человеческой деятельности. Исследования показывают, что более запоминающиеся визуальные стимулы обрабатываются мозгом интенсивнее, что приводит к более прочному закреплению в долговременной памяти. Это имеет непосредственное отношение к таким областям, как реклама, где создание визуально привлекательных и легко запоминающихся образов является залогом успеха кампании. Не менее важна визуальная запоминаемость в процессе распознавания лиц, когда мозг мгновенно извлекает из памяти информацию о знакомых людях, основываясь на визуальных характеристиках. Таким образом, понимание механизмов, определяющих визуальную запоминаемость, открывает возможности для разработки более эффективных стратегий в дизайне, маркетинге и даже в системах искусственного интеллекта, стремящихся к моделированию человеческого познания.

Существующие наборы данных для обучения искусственного интеллекта часто оказываются недостаточно детализированными для адекватного моделирования сложности человеческого процесса вспоминания. Это препятствует прогрессу в области мультимодального ИИ, требующего понимания, как люди извлекают информацию из различных источников. Для решения этой проблемы был разработан ToT2MeM — масштабный набор данных, включающий более 470 000 пар “контент — воспоминание”. ToT2MeM призван предоставить более реалистичную основу для обучения моделей ИИ, позволяя им лучше понимать и воспроизводить нюансы человеческой памяти и, как следствие, значительно улучшить качество работы систем распознавания и извлечения информации.

ToT2MeM: Набор Данных, Отражающий Сигналы Человеческого Воспоминания

Набор данных ToT2MeM сформирован на основе онлайн-форумов, посвященных состоянию «на кончике языка», что обеспечивает богатый источник естественных попыток вспоминания. Он содержит более 470 000 пар «описание — вспоминаемое содержание», собранных из реальных запросов пользователей. Этот подход позволяет получить данные, отражающие типичные процессы вспоминания, а не искусственно созданные сценарии, что делает набор данных ценным для обучения моделей, способных моделировать человеческую память.

Набор данных ToT2MeM отличается от традиционных подходов к сопоставлению изображений и текста тем, что фиксирует описательные сигналы, связанные с частичным вспоминанием информации. В отличие от наборов данных, ориентированных исключительно на успешное извлечение данных, ToT2MeM регистрирует описания, которые пользователи предоставляют в попытке вспомнить информацию, когда полное воспоминание недоступно. Это включает в себя вербальные описания, связанные с искомым контентом, такие как характеристики, атрибуты или связанные понятия, что позволяет моделировать не только конечный результат поиска, но и сам процесс извлечения информации из памяти.

Набор данных ToT2MeM отличается от традиционных подходов к обучению моделей поиска информации, поскольку он фокусируется не на успешном извлечении данных, а на процессе вспоминания. Вместо пар «запрос-результат», ToT2MeM содержит данные, отражающие частичные попытки вспомнить информацию, включая описательные сигналы, возникающие при «ощущении на кончике языка». Это позволяет обучать модели генерировать более естественные подсказки и сигналы, имитирующие процесс человеческого воспоминания, что может повысить эффективность и реалистичность систем поиска и извлечения информации. Обучение на таких данных позволяет создавать модели, способные предоставлять не только точные результаты, но и полезные подсказки для пользователя, находящегося в процессе вспоминания.

Описательное Воспоминание с Использованием Визуально-Языковых Моделей

Для повышения эффективности обучения моделей обработки изображений и текста, мы провели тонкую настройку передовых моделей QwenVL и InternVL на наборе данных ToT2MeM с использованием метода Low Rank Adaptation (LoRA). LoRA позволяет оптимизировать только небольшое количество параметров модели, что значительно снижает вычислительные затраты и требования к памяти по сравнению с полной перенастройкой всех параметров. Данный подход позволил добиться значительного улучшения производительности моделей при решении задач, связанных с извлечением информации из визуального контента и генерацией соответствующих текстовых описаний.

В процессе обучения модели QwenVL и InternVL на наборе данных ToT2MeM, применялась методика, направленная на генерацию текстовых описаний визуального контента. Целью являлось создание системы, способной воспроизводить когнитивный процесс человеческой памяти, а именно — формирование релевантных сигналов для извлечения информации из визуальных данных. Модели обучались не просто распознавать объекты на изображении, а генерировать детальные описания, которые, подобно ассоциациям в человеческой памяти, облегчают последующий поиск и извлечение информации, связанной с данным визуальным стимулом.

В результате обучения моделей QwenVL и InternVL на наборе данных ToT2MeM продемонстрирована улучшенная способность генерировать релевантные сигналы для извлечения информации из памяти. Это подтверждается достижением точности в топ-5 в задачах мультимодального поиска по принципу “на кончике языка”, где модели способны извлечь корректное видео из первых пяти предложенных вариантов. Такой результат указывает на эффективность моделей в имитации процесса человеческого воспоминания и извлечения визуальной информации.

Подтверждение Сгенерированных Моделью Сигналов Воспоминания Экспертами

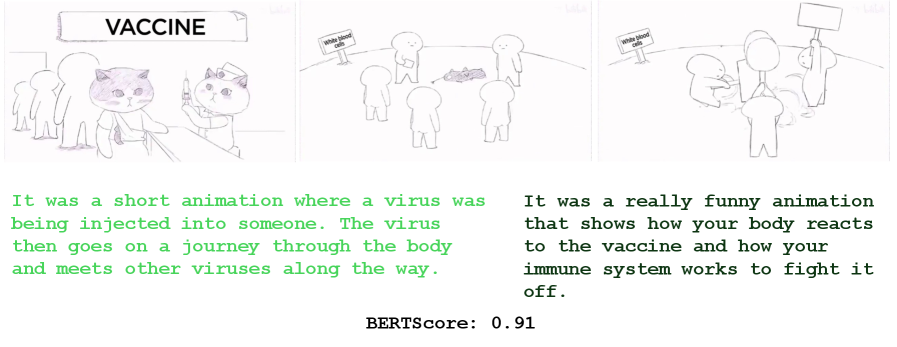

В ходе исследования участникам предъявлялись описательные подсказки, сгенерированные моделью искусственного интеллекта, после чего им предлагалось воссоздать исходные сцены с использованием генеративной модели изображений Stable Diffusion. Этот подход позволил оценить, насколько эффективно модель способна передавать визуальную информацию в форме, понятной для человека и достаточной для последующей реконструкции изображения. Участники, получив текстовое описание, генерировали новое изображение, которое затем сравнивалось с оригиналом, демонстрируя возможности модели в создании информативных и понятных подсказок для воссоздания визуальных образов.

Для оценки точности реконструкций, выполненных на основе подсказок, применялась метрика BERTScore. Данный показатель измеряет семантическую близость между воссозданными изображениями и исходными сценами, учитывая контекст и смысл, а не просто совпадение пикселей. BERTScore, основанный на глубоких трансформерах, позволяет более точно оценить, насколько успешно модель передала суть визуальной информации и воссоздала ее в новом изображении. Высокие значения BERTScore свидетельствуют о том, что воссозданные сцены не только визуально похожи на оригиналы, но и сохраняют их семантическое содержание, что является ключевым показателем успешной работы системы генерации подсказок.

В ходе экспериментов, разработанные модели продемонстрировали способность к генерации подсказок, позволяющих эффективно воссоздавать исходные визуальные сцены. Оценка качества этих подсказок, произведенная с помощью метрик BLEU и ROUGE-1, выявила значения до 0.61 и 0.62 соответственно в наиболее успешных примерах. Данные показатели свидетельствуют о том, что модели способны улавливать и передавать суть визуальной запоминаемости, то есть, генерировать описания, которые позволяют воссоздать не просто технически похожие изображения, а именно те, что вызывают сходные ассоциации и ощущения у наблюдателя. Это указывает на перспективность использования подобных моделей для задач, связанных с памятью и визуальным поиском.

Исследование, представленное в статье, демонстрирует, как легко можно создать иллюзию прогресса, собирая данные из, казалось бы, неструктурированных источников — в данном случае, форумов о забытых словах. Это напоминает о неизбежной энтропии в любой системе. Как заметил Джеффри Хинтон: «Я думаю, что мы сейчас в начале пути, и я надеюсь, что мы сможем создать машины, которые будут думать как люди». Но, наблюдая за тем, как алгоритмы «вспоминают» визуальную информацию на основе фрагментарных запросов, становится ясно: это не интеллект, а лишь ещё более изощрённый способ маскировки технических долгов. Вместо реального понимания, мы получаем впечатляющие, но хрупкие конструкции, которые неизбежно потребуют постоянного обслуживания и доработки. И вся эта «генерация описаний», и «мультимодальный поиск» — лишь новые слои абстракции, скрывающие фундаментальную сложность задачи.

Что дальше?

Создание датасета из форумов о «забытых словах» — это, конечно, элегантно. Но давайте будем честны: через полгода кто-нибудь прикрутит к этому генеративную модель, назовёт это «AI-powered memory augmentation» и получит финансирование. А датасет ToT2MeM станет просто ещё одним слоем абстракции, над которым никто не будет разбираться. Всё вернётся к простому bash-скрипту, который когда-то решал эту задачу, только с огромными вычислительными затратами.

Проблема визуальной запоминаемости, как и любая другая в когнитивной науке, остаётся нерешённой. Улучшение метрик по «описательному recall» — это хорошо, но что это даёт на практике? Очевидно, что текущие модели отлично умеют воспроизводить паттерны, но абсолютно не понимают суть. И, вероятно, никогда не поймут. Документация, как обычно, соврёт, и мы будем тратить время на отладку.

Начинают подозревать, что вся эта «мультимодальная извлекаемость» — просто перефразирование старых идей. И это, пожалуй, самое печальное. Технический долг — это просто эмоциональный долг с коммитами. Так что, возможно, стоит просто вернуться к карандашу и бумаге. Или хотя бы к более простому коду.

Оригинал статьи: https://arxiv.org/pdf/2511.20854.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Что такое Bazzite и лучше ли она, чем Windows для PC-гейминга? Я установил этот набирающий популярность дистрибутив Linux, чтобы проверить это самостоятельно.

- Санкционный удар по России: Минфин США расширяет список ограничений – что ждет экономику? (25.02.2026 05:32)

- Новые смартфоны. Что купить в марте 2026.

- Неважно, на что вы фотографируете!

- vivo X300 FE ОБЗОР: портретная/зум камера, беспроводная зарядка, объёмный накопитель

- Microsoft Edge позволяет воспроизводить YouTube в фоновом режиме на Android — подписка Premium не требуется.

- Восстановление 3D и спектрального изображения растений с помощью нейронных сетей

- Умные Поверхности для Сетей Будущего: Новый Шаг к 6G

- Cubot X100 ОБЗОР: отличная камера, удобный сенсор отпечатков, плавный интерфейс

- Как установить Virtualbox на Windows 11 для бесплатных виртуальных машин

2025-11-28 19:14