Автор: Денис Аветисян

Новое исследование показывает, что механизм внимания в больших языковых моделях функционирует аналогично человеческой памяти, опираясь на контекстные ключи для хранения и извлечения данных.

Пока крипто-инвесторы ловят иксы и ликвидации, мы тут скучно изучаем отчетность и ждем дивиденды. Если тебе близка эта скука, добро пожаловать.

Купить акции "голубых фишек"

Работа раскрывает принципы работы внимания в трансформерах, вдохновленные принципом специфичности кодирования, и предлагает новые подходы к объяснимому ИИ и машинному забыванию.

Несмотря на растущий интерес к объяснимому искусственному интеллекту (XAI) для больших языковых моделей (LLM), конкретная роль механизмов внимания в трансформаторах остается малоизученной. В своей работе ‘Memory Retrieval in Transformers: Insights from The Encoding Specificity Principle’ авторы исследуют, как слои внимания реализуют механизмы памяти, опираясь на принципы когнитивной психологии и компьютэрной психолингвистики. Полученные результаты демонстрируют, что внимание в LLM функционирует аналогично извлечению информации из человеческой памяти, используя ключевые слова как контекстные сигналы для хранения и восстановления информации. Возможно ли, опираясь на эти принципы, разработать более эффективные методы машинного разучения и обеспечить прозрачность работы LLM?

Эхо памяти: Основы внимания

В когнитивной науке давно установлено, что извлечение воспоминаний происходит посредством сигналов — своеобразных подсказок, активирующих доступ к хранимой информации. Теории, основанные на сигналах, объясняют этот процесс, подчеркивая, что воспоминания не являются пассивными хранилищами, а активно реконструируются на основе доступных стимулов. Эти сигналы могут быть разнообразными — запахи, звуки, визуальные образы или даже эмоциональное состояние, — и их эффективность напрямую зависит от силы связи между сигналом и исходным опытом. Таким образом, процесс воспоминания представляет собой динамическое взаимодействие между текущим контекстом и хранящимися в памяти следами, где сигналы выступают в роли катализаторов, запускающих процесс поиска и реконструкции прошлого опыта.

Принцип специфичности кодирования (ESP) подчеркивает, что извлечение информации из памяти наиболее эффективно, когда стимулы-триггеры максимально соответствуют условиям, в которых эта информация была изначально закодирована. Иными словами, воспоминания легче восстанавливаются, если окружающая обстановка или контекст при извлечении напоминает тот, что был при формировании этого воспоминания. Это явление объясняется тем, что информация в памяти не хранится изолированно, а связана с контекстом, и этот контекст служит ключом к ее активации. Чем больше совпадений между контекстом кодирования и извлечения, тем более вероятным становится успешное восстановление информации, что демонстрирует глубокую взаимосвязь между памятью и окружающей средой.

Принципы работы памяти, основанные на извлечении информации по подсказкам и контекстуальной специфике, предлагают интересную параллель для искусственного интеллекта. В частности, они вдохновили создание механизмов внимания в современных больших языковых моделях (LLM), которые позволяют им фокусироваться на релевантной информации, подобно тому, как мозг извлекает воспоминания на основе контекста. Однако, несмотря на кажущуюся эффективность, LLM демонстрируют значительную хрупкость «памяти» — до 90% случаев «галлюцинаций» возникают при искусственном изменении оценок значимости информации. Этот факт подчеркивает, что текущие механизмы внимания в LLM, хотя и имитируют некоторые аспекты человеческой памяти, не обладают той же устойчивостью и надежностью, что и биологические системы, и нуждаются в дальнейшем совершенствовании для достижения действительно «осмысленного» извлечения информации.

Ключ-значение: Архитектура внимания

Механизм внимания использует фреймворк «ключ-значение» для моделирования хранения и извлечения информации, аналогичный принципам работы человеческой памяти. В данной архитектуре, информация сохраняется в виде пар: ключ (K) и значение (V), где ключ функционирует как индекс для поиска, а значение содержит фактические данные. Этот подход позволяет системе эффективно извлекать релевантную информацию, аналогично тому, как человек находит воспоминания, используя ассоциативные связи и ключевые слова для доступа к соответствующим данным в памяти.

В ключевой архитектуре памяти, используемой в механизмах внимания, информация структурируется в виде пар «Ключ-Значение» (Key-Value). Ключ (K) функционирует как индекс или идентификатор, позволяющий быстро находить соответствующую информацию. Значение (V) содержит фактические данные, связанные с этим ключом. Такая организация позволяет системе эффективно извлекать информацию, сопоставляя входной запрос (Query) с существующими ключами для определения релевантных значений. По сути, ключи обеспечивают адресность данных, а значения — сами данные, что является основой для процесса извлечения информации, имитирующего принципы работы человеческой памяти.

В рамках механизма внимания, запрос (Q) используется для поиска релевантной информации путем сопоставления с ключами (K). Степень соответствия определяет величину внимания, уделяемого соответствующему значению (V). Однако, экспериментальные данные показывают, что даже при высоких значениях внимания, большие языковые модели (LLM) демонстрируют 100% склонность к галлюцинациям при использовании фактических запросов в сочетании с заменой ключей и значений (KK & VV). Это указывает на то, что высокая степень внимания не гарантирует фактическую достоверность извлекаемой информации и не предотвращает генерацию ложных утверждений.

Адресная память по содержанию: Новый подход

Фреймворк «Ключ-Значение» (Key-Value Memory Framework) реализует концепцию Content-Addressable Memory (CAM), что позволяет осуществлять поиск и извлечение информации на основе её семантического содержания, а не физического адреса в памяти. В отличие от традиционных методов, где доступ к данным осуществляется по заранее определенным адресам, CAM использует «ключи», представляющие собой семантические векторы, полученные из входных данных. При запросе информации, система сравнивает запрос с этими ключами, идентифицируя и извлекая соответствующие «значения» — фактические данные, связанные с ключом. Это обеспечивает более гибкий и эффективный доступ к информации, особенно в случаях, когда точное местоположение данных неизвестно или изменяется.

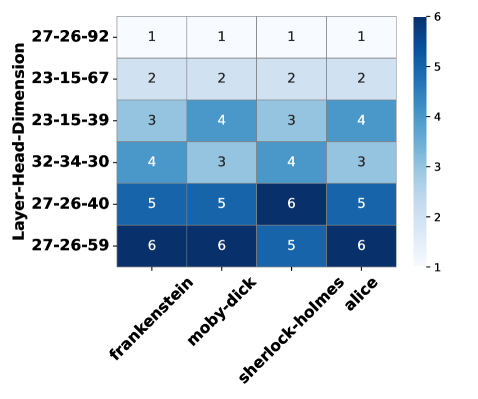

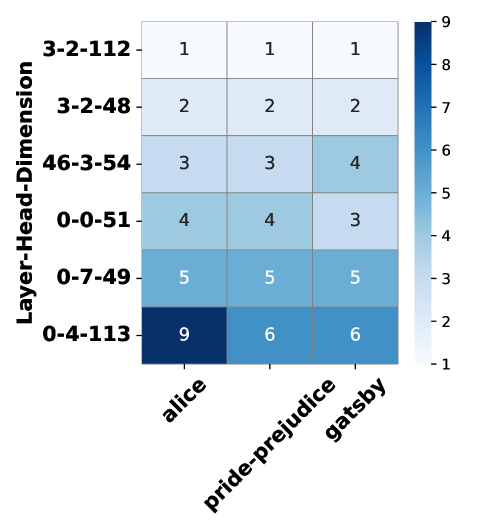

Контекстные сигналы играют критическую роль в определении и уточнении ключей в системах, реализующих ассоциативную память. Использование контекста позволяет эффективно извлекать релевантную информацию даже в сложных сценариях, где однозначное сопоставление по прямому адресу невозможно. Экспериментальные данные показывают, что намеренное возмущение этих ключевых слов в слоях внимания приводит к значительному снижению метрики ROUGE-L Recall, что подтверждает их важность для обеспечения точности извлечения информации и демонстрирует чувствительность системы к изменениям в представлении контекста.

Эксперименты с заменой векторных проекций значений (Value projections, VV) в рамках архитектуры Key-Value Memory показали вариативность точности восстановления информации в диапазоне от 50% до 100% в зависимости от используемой модели. Данный диапазон свидетельствует о высокой чувствительности системы к незначительным изменениям в представлении данных в памяти. Нестабильность точности при замене VV указывает на необходимость тщательной калибровки и оптимизации процесса проекции значений для обеспечения надежной работы системы Content-Addressable Memory и сохранения качества извлечения релевантной информации.

Исследование демонстрирует, что трансформеры, подобно человеческой памяти, активно используют контекстные ключи для хранения и извлечения информации. Внимание, направленное на определенные элементы входных данных, функционирует как механизм, позволяющий находить и восстанавливать релевантные фрагменты. Этот процесс напоминает принцип специфичности кодирования, где извлечение информации зависит от соответствия между контекстом при кодировании и контекстом при извлечении. Как заметил Винтон Серф: «Интернет — это не просто технология, это способ организации информации». Эта фраза отражает суть работы трансформеров — организация огромного объема информации и предоставление доступа к ней по контекстным ключам. Хорошая архитектура незаметна, пока не ломается, и только тогда видна настоящая цена решений.

Куда двигаться дальше?

Представленная работа, выявляя параллели между механизмами внимания в Transformer-моделях и принципами работы человеческой памяти, лишь слегка приоткрывает завесу над сложной архитектурой этих систем. Полагаться на аналогию с памятью — удобно, но опасно; мы оптимизируем не то, что нужно, если не осознаём фундаментальных различий. Идея о контекстных ключах, хранящихся в слоях внимания, интригует, однако, вопрос о масштабируемости этой «памяти» остаётся открытым. Простота масштабируется, изощрённость — нет, и пока неясно, где проходит эта граница.

Настоящая цена свободы — зависимости, и в данном случае — зависимость от определённых типов контекстных ключей. Как обеспечить устойчивость системы к манипуляциям этими ключами? Как защитить «воспоминания» модели от искажений и неполноты? И, самое главное, как разработать эффективные методы «забывания» — истинного машинного «необучения» — не нарушая при этом целостность всей системы? Хорошая архитектура незаметна, пока не ломается, и нам предстоит долгий путь, чтобы создать архитектуру, способную к адаптации и восстановлению.

Перспективы кажутся многообещающими, но необходимо помнить: ключ к пониманию не в создании всё более сложных моделей, а в углублении понимания принципов, лежащих в их основе. Необходимо сместить фокус с оптимизации отдельных компонентов на создание системы, способной к самоорганизации и эволюции. Иначе, мы рискуем создать лишь иллюзию интеллекта, замаскированную под сложной архитектурой.

Оригинал статьи: https://arxiv.org/pdf/2601.20282.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Российский рынок: Оптимизм на фоне трехсторонних переговоров – чего ждать 1 февраля? (25.01.2026 17:32)

- Новые смартфоны. Что купить в январе 2026.

- Сургутнефтегаз акции привилегированные прогноз. Цена SNGSP

- Российский рынок акций: Ралли на фоне нефти, золота и смягчения ДКП (28.01.2026 16:32)

- Российская экономика 2025: Рекорды энергопотребления, падение добычи и укрепление рубля (22.01.2026 17:32)

- vivo X300 Ultra ОБЗОР: беспроводная зарядка, замедленная съёмка видео, портретная/зум камера

- Типы дисплеев. Какой монитор выбрать?

- Неважно, на что вы фотографируете!

- Тепловая Сфера: Восстановление 3D-сцен из RGB и Тепловидения

- Обзор Fujifilm X-E2

2026-01-29 19:20