Автор: Денис Аветисян

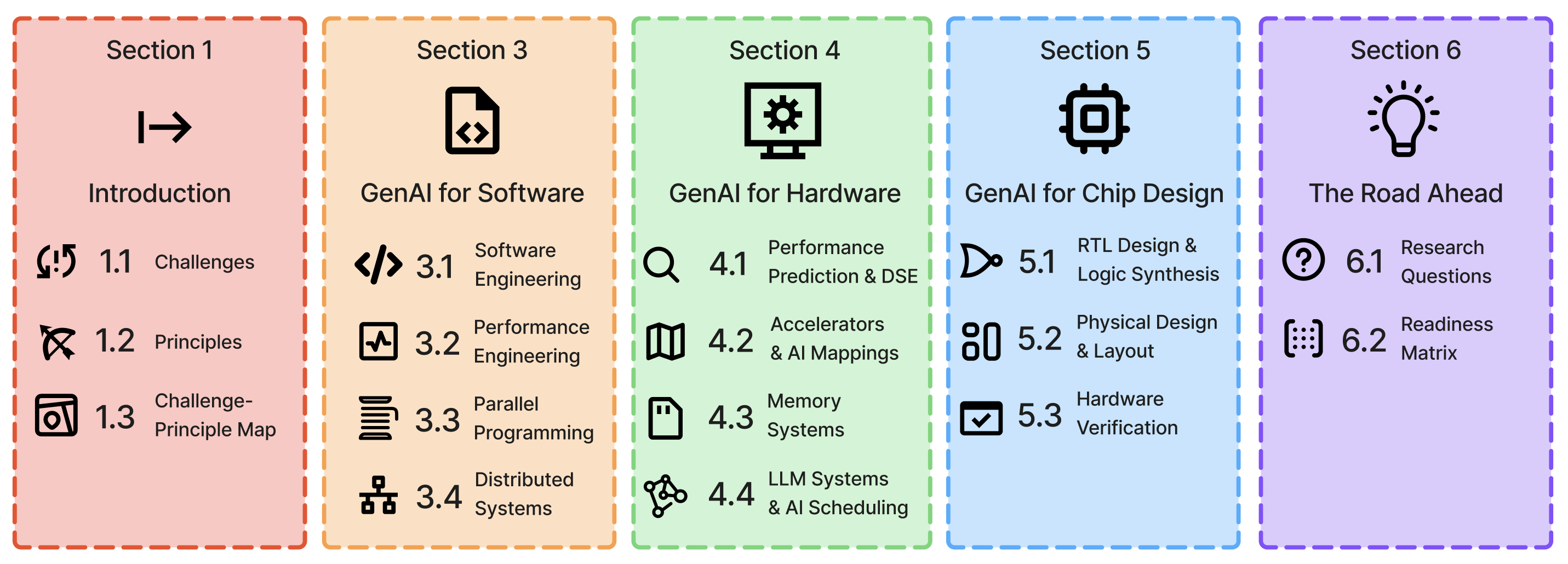

Обзор показывает, как генеративный искусственный интеллект преобразует весь вычислительный стек, от программного обеспечения до аппаратного обеспечения, и выявляет ключевые проблемы и принципы, необходимые для успешного внедрения.

Пока крипто-инвесторы ловят иксы и ликвидации, мы тут скучно изучаем отчетность и ждем дивиденды. Если тебе близка эта скука, добро пожаловать.

Купить акции "голубых фишек"

Систематический анализ применения генеративного ИИ в инженерии систем, охватывающий оптимизацию и автоматизацию на всех уровнях, от разработки программного обеспечения до проектирования кремния.

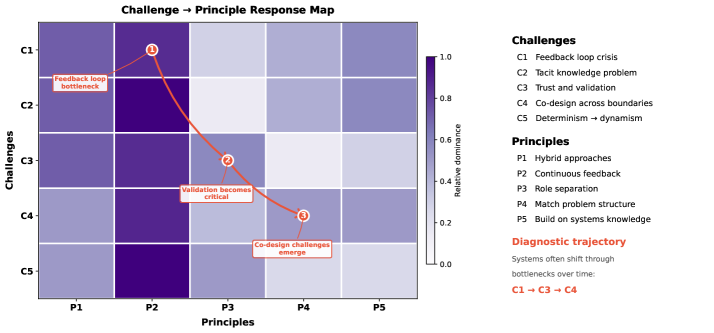

Несмотря на стремительное развитие генеративного искусственного интеллекта, его применение в проектировании вычислительных систем остается фрагментированным. В работе ‘GenAI for Systems: Recurring Challenges and Design Principles from Software to Silicon’ представлен междисциплинарный анализ применения генеративных моделей — от генерации кода до синтеза аппаратного обеспечения — с выявлением повторяющихся проблем и эффективных принципов проектирования на всех уровнях стека. Ключевой вывод исследования заключается в том, что, несмотря на разнообразие областей применения, поле неизменно сталкивается с пятью основными вызовами и приходит к пяти общим принципам, обеспечивающим эффективные решения. Каким образом систематизация этих принципов и вызовов может ускорить прогресс в области автоматизированного проектирования вычислительных систем и обеспечить более эффективное взаимодействие между разработчиками программного и аппаратного обеспечения?

Пределы Традиционного Проектирования Систем

Традиционные подходы к проектированию систем часто сталкиваются с проблемой растущей сложности, что приводит к созданию хрупких и трудно поддерживаемых конструкций. По мере увеличения масштаба и функциональности систем, взаимосвязи между компонентами становятся все более запутанными, что затрудняет внесение изменений и исправление ошибок. Любое незначительное изменение в одной части системы может непредсказуемо повлиять на другие, вызывая каскад отказов и требуя значительных усилий для отладки. Такая архитектура, лишенная гибкости и устойчивости, становится серьезным препятствием для инноваций и оперативной адаптации к изменяющимся требованиям, увеличивая затраты на сопровождение и снижая общую надежность системы.

Одной из ключевых проблем при проектировании сложных систем остается фиксация и представление неявных знаний, накопленных опытными инженерами. Эти знания, часто выраженные в виде интуиции, «чувства» системы и умения быстро находить решения в нестандартных ситуациях, сложно формализовать и перенести в автоматизированные инструменты. Отсутствие возможности эффективно передавать такой опыт существенно ограничивает возможности автоматизации процессов проектирования, затрудняет масштабирование систем и увеличивает зависимость от узкого круга специалистов. В результате, возникает риск потери критически важных знаний при уходе опытных сотрудников, а также замедляется адаптация систем к изменяющимся требованиям и новым технологиям. Преодоление этой проблемы требует разработки новых методов и инструментов, способных извлекать, кодировать и применять неявные знания в процессе проектирования и эксплуатации сложных систем.

Современные системы предъявляют всё более высокие требования к производительности, надёжности и масштабируемости, что обостряет существующие ограничения традиционных подходов к проектированию. Растущая сложность архитектур и увеличение объёма данных приводят к снижению управляемости и повышению вероятности ошибок, что делает существующие решения всё менее пригодными для решения новых задач. В связи с этим, наблюдается активный поиск альтернативных методологий, направленных на создание более устойчивых и адаптивных систем, способных эффективно функционировать в условиях постоянно меняющейся среды и удовлетворять растущие потребности пользователей. Особое внимание уделяется автоматизации процессов проектирования и разработки, а также использованию принципов модульности и декомпозиции для упрощения управления сложностью.

![По мере увеличения масштаба и разнородности вычислительных систем, модели предсказания производительности эволюционировали от простых регрессионных моделей к сложным глубоким графовым сетям, гибридным аналитико-ML системам и регрессионным языковым моделям[69,27,162,119,210,7,257].](https://arxiv.org/html/2602.15241v1/Figures/system_model_complexity.png)

Генеративный ИИ: Новый Подход к Автоматизации

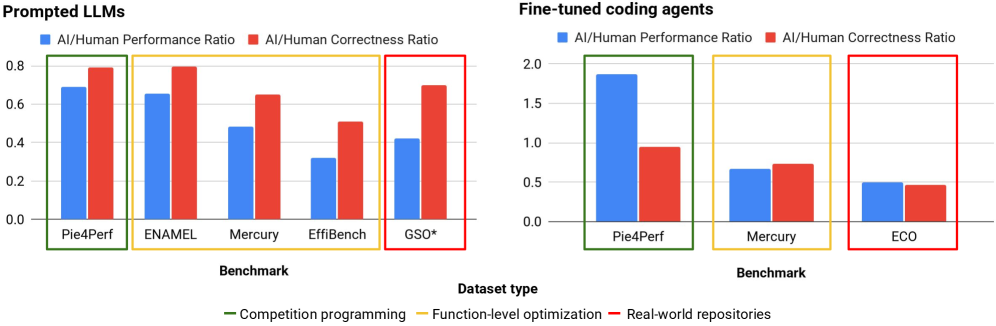

Генеративный искусственный интеллект (ИИ) предоставляет мощный набор инструментов для автоматизации проектирования и оптимизации на всех уровнях вычислительной системы, начиная от аппаратного обеспечения и заканчивая программным обеспечением. Этот подход позволяет автоматизировать задачи, которые традиционно требовали значительных усилий инженеров, включая разработку новых архитектур процессоров, оптимизацию схем и создание программного кода. Возможности генеративного ИИ охватывают широкий спектр применения, включая автоматическую генерацию и верификацию RTL-кода, оптимизацию энергопотребления, а также поиск оптимальных конфигураций для различных вычислительных задач. Применение генеративного ИИ позволяет значительно ускорить процесс проектирования, снизить затраты и повысить производительность и эффективность конечных продуктов.

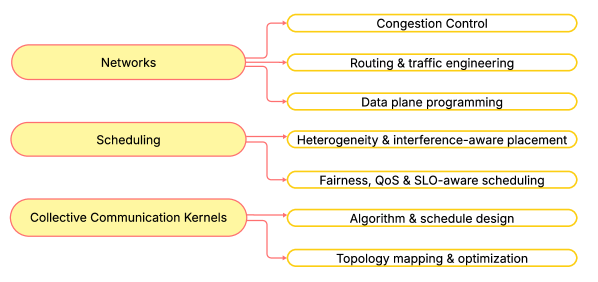

Методы, такие как агентные системы и оптимизация на основе данных, позволяют исследовать значительно расширенные пространства проектирования, недоступные для ручного анализа инженерами. Агентные системы, состоящие из множества взаимодействующих агентов, способны параллельно оценивать различные варианты решений, в то время как оптимизация на основе данных использует алгоритмы машинного обучения для выявления закономерностей и поиска оптимальных конфигураций. Это особенно актуально для задач высокой сложности, где количество возможных решений экспоненциально растет, и традиционные методы проектирования становятся неэффективными. Использование этих методов позволяет находить нетривиальные и инновационные решения, которые повышают производительность, снижают энергопотребление и сокращают время разработки.

Применение генеративного искусственного интеллекта (ИИ) в разработке RTL-схем (Register-Transfer Level) позволяет значительно улучшить ключевые характеристики проектируемых чипов. Традиционно, оптимизация RTL-кода для достижения максимальной производительности и минимального энергопотребления требовала недель кропотливой работы инженеров. Генеративный ИИ, используя алгоритмы машинного обучения, способен исследовать огромное пространство вариантов дизайна и находить решения, недоступные для ручной оптимизации. В результате, наблюдается существенное повышение производительности, снижение энергопотребления и сокращение времени проектирования с недель до часов, что позволяет значительно ускорить вывод новых микросхем на рынок.

Обеспечение Надёжности и Доверия с Помощью Формальных Методов

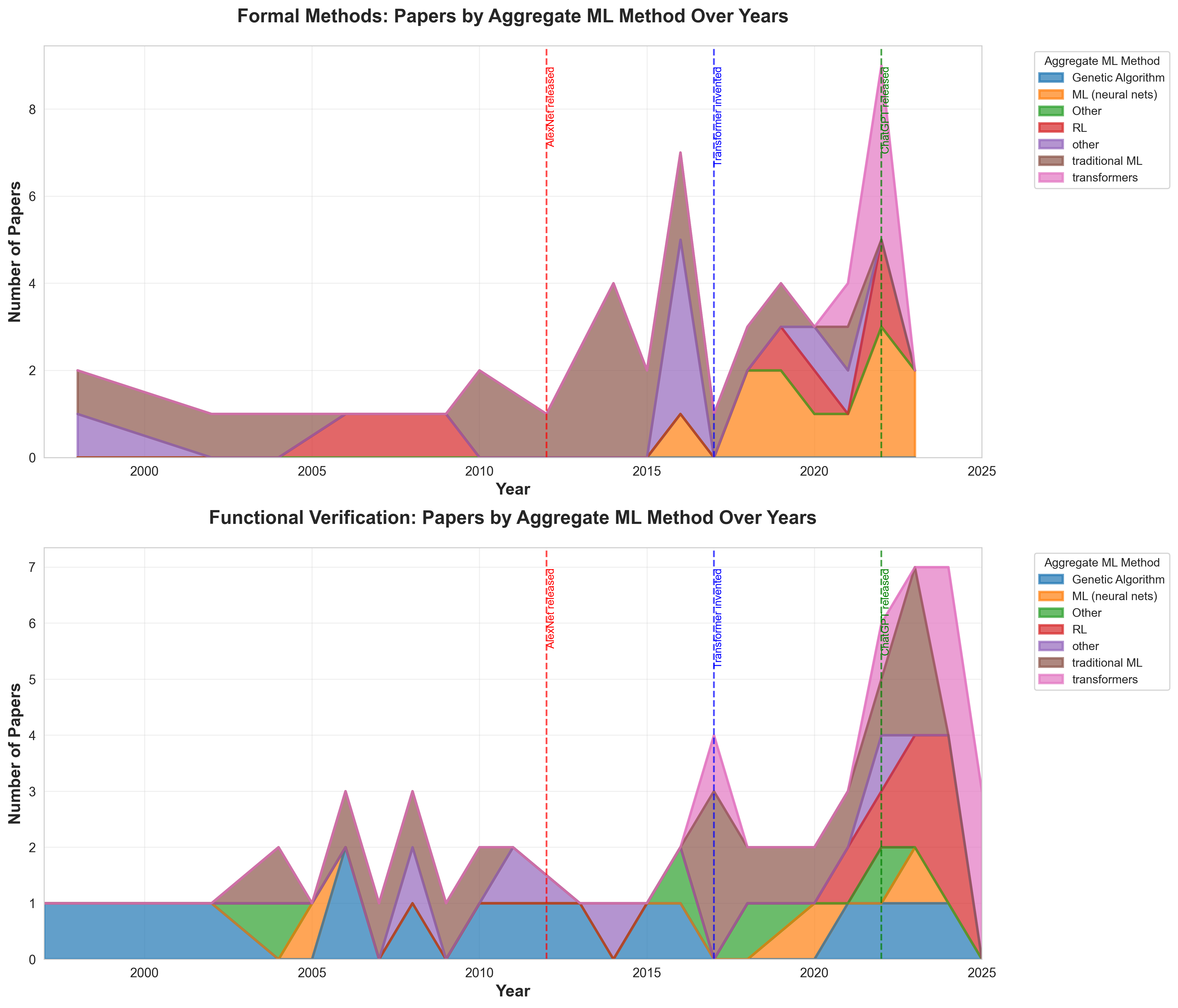

Несмотря на свою мощь, результаты, генерируемые моделями искусственного интеллекта, требуют тщательной валидации для обеспечения корректности и надежности, особенно в приложениях, критичных к безопасности. Отсутствие верификации может привести к непредсказуемым ошибкам и сбоям в системах, где последствия могут быть серьезными, например, в авиации, медицине или автономном транспорте. Процесс валидации включает в себя не только тестирование на известных наборах данных, но и формальную верификацию, направленную на доказательство соответствия с заданными спецификациями и требованиям. Особое внимание уделяется обработке граничных случаев и нештатных ситуаций, которые могут быть недостаточно представлены в обучающих данных.

Формальные методы обеспечивают проверку поведения систем на основе математических принципов, что позволяет гарантировать соответствие системы заданным спецификациям. В отличие от традиционных методов тестирования, которые могут охватывать лишь часть возможных сценариев, формальные методы позволяют доказать корректность системы для всех возможных входных данных и состояний. Это достигается путем моделирования системы в формальной логике и использования математических теорем и алгоритмов для доказательства ее свойств. Применение формальных методов демонстрирует значительное увеличение покрытия верификацией, часто приближаясь к 100%, в то время как традиционные методы обычно обеспечивают покрытие лишь в пределах 60-80%. \exists x \in S : P(x) — пример формальной спецификации, где S — множество состояний, а P(x) — свойство, которое должно выполняться. Такой подход особенно важен для систем, где ошибки могут привести к серьезным последствиям, например, в авиационной промышленности или системах управления ядерными реакторами.

Комбинирование генеративного ИИ с формальными методами позволяет создать замкнутый цикл автоматизированного проектирования и строгой верификации. Генеративный ИИ способен автоматизировать создание начальных вариантов дизайна и кода, в то время как формальные методы обеспечивают математическую проверку этих проектов на соответствие заданным спецификациям и требованиям безопасности. Результаты верификации, полученные с помощью формальных методов, могут быть использованы для улучшения моделей генеративного ИИ посредством обучения с подкреплением или других методов, что повышает качество генерируемого кода и сокращает количество ошибок. Такой итеративный процесс, объединяющий автоматизацию и строгую проверку, способствует созданию надежных и предсказуемых систем, особенно критичных для безопасности, где необходима гарантия корректности функционирования.

Кросс-уровневый Анализ для Холистической Оптимизации Системы

Часто встречается ситуация, когда оптимизация отдельных компонентов вычислительной системы, осуществляемая вне связи с остальными, приводит к далеко не оптимальным результатам в целом. Это связано с тем, что производительность системы определяется не суммой производительностей её частей, а взаимодействием между ними. Например, улучшение скорости работы процессора может быть нивелировано узким местом в подсистеме памяти или недостаточной пропускной способностью сети. Вместо улучшения общей картины, изолированная оптимизация может даже ухудшить ситуацию, создавая дисбаланс и приводя к неэффективному использованию ресурсов. Поэтому для достижения максимальной производительности необходимо рассматривать систему как единое целое и оптимизировать её компоненты с учётом их взаимосвязей и влияния друг на друга.

Анализ, охватывающий различные уровни вычислительного стека, позволяет выявить общие проблемы и основополагающие принципы, которые ранее оставались незамеченными при изолированной оптимизации отдельных компонентов. Такой подход позволяет перейти от локальных улучшений к поиску синергетических решений, где оптимизация на одном уровне положительно влияет на производительность других. Исследование выявляет, что многие ограничения и возможности проистекают из взаимодействия между слоями, а не из специфики каждого слоя по отдельности. Это особенно важно в современных вычислительных системах, где сложность взаимодействия между аппаратным и программным обеспечением требует целостного взгляда для достижения оптимальной производительности и эффективности.

Систематический инженерный подход, подкрепленный межслойным бенчмаркингом, представляется ключевым для раскрытия полного потенциала генеративного искусственного интеллекта и формальных методов. Исследования показывают, что оптимизация отдельных компонентов в отрыве друг от друга часто приводит к субоптимальным результатам. В настоящее время данный подход активно тестируется на масштабных наборах данных, включающих до миллиона сгенерированных планов размещения (floorplans), что позволяет оценить эффективность комплексной оптимизации и выявить синергетические эффекты между различными слоями вычислительной системы. Полученные данные демонстрируют значительное улучшение производительности и надежности при использовании межслойного анализа, открывая новые возможности для разработки более интеллектуальных и эффективных систем.

Будущее: Непрерывный Цикл Обратной Связи и Адаптивные Системы

Для обеспечения непрерывного совершенствования и адаптации систем, критически важным является замыкание цикла обратной связи между этапами генерации и оценки. В традиционных подходах эти процессы часто разделены, что затрудняет автоматическую корректировку и оптимизацию. Замыкание цикла позволяет системе анализировать результаты своей работы, выявлять ошибки и неэффективности, а затем использовать эту информацию для улучшения последующих итераций. Это особенно важно в контексте постоянно усложняющихся систем, таких как микроэлектроника, где ручная оптимизация становится невозможной из-за огромного количества параметров и слоев.

Для преодоления кризиса обратной связи требуется внедрение надежного мониторинга, автоматизированного тестирования и способности к обучению на основе данных, полученных из реальной эксплуатации. Это подразумевает создание систем, способных непрерывно отслеживать свою производительность в различных условиях, выявлять отклонения от заданных параметров и автоматически корректировать свою работу. Автоматизированные тесты, охватывающие широкий спектр сценариев использования, позволяют оперативно обнаруживать ошибки и уязвимости, а сбор и анализ данных из реального мира — адаптировать алгоритмы и модели к изменяющимся условиям эксплуатации. Такой подход позволяет не только повысить надежность и эффективность систем, но и существенно сократить время и затраты на их обслуживание и модернизацию, обеспечивая непрерывное улучшение характеристик на протяжении всего жизненного цикла.

Разработка систем, способных к проактивной адаптации к изменяющимся условиям и оптимизации производительности на протяжении всего жизненного цикла, представляет собой ключевой вектор развития современной инженерии. Эти системы, в отличие от статических решений, смогут динамически перестраивать свою архитектуру и алгоритмы, реагируя на внешние факторы и внутренние изменения. Особенно актуально это в контексте постоянно усложняющихся микроэлектронных схем, где количество транзисторов и слоев растет экспоненциально. Способность автоматически корректировать параметры и оптимизировать энергопотребление позволит создавать более надежные, эффективные и долговечные устройства, способные функционировать в широком диапазоне условий и сохранять оптимальную производительность даже при увеличении сложности и масштаба проектируемых схем. Такой подход открывает возможности для создания самообучающихся и самооптимизирующихся систем, способных решать задачи, недоступные традиционным решениям.

Работа демонстрирует, что генеративный искусственный интеллект, несмотря на всю шумиху, сталкивается с теми же проблемами, что и традиционная разработка систем. Авторы справедливо отмечают необходимость сквозной оптимизации и проектирования, а не просто применения модных алгоритмов к отдельным слоям стека. Как заметил Роберт Тарьян: «Самое сложное в программировании — это не писать код, а понимать, что нужно написать». Эта фраза как нельзя лучше отражает суть исследования — даже самые передовые инструменты не решат проблемы, если отсутствует ясное понимание системных требований и ограничений. В конечном итоге, система стабильно падает не из-за недостатка «AI», а из-за ошибок в проектировании.

Что дальше?

Рассмотренные подходы к применению генеративного искусственного интеллекта во всей вычислительной системе, несомненно, выглядят многообещающе. Однако, за красивыми схемами кроется старая проблема: автоматизация всегда упрощает видимую сложность, добавляя новую, скрытую. Каждый новый слой абстракции — это лишь очередная возможность для возникновения неочевидных ошибок. Похоже, что принцип «всё работало, пока не пришёл AI» скоро станет новой аксиомой.

Очевидно, что ключевым препятствием остаётся верификация. Автоматически сгенерированный код или архитектура могут казаться оптимальными, но кто гарантирует их корректность? На практике, скорее всего, придётся изобретать новые методы формальной верификации, которые смогут справиться с экспоненциальным ростом сложности. Иначе, мы получим системы, которые «работают» до первого критического сбоя.

В конечном итоге, всё это сводится к старому правилу: новое — это хорошо забытое старое с худшей документацией. Генеративный ИИ — это инструмент, и, как любой инструмент, он требует умелого использования. И, судя по всему, инженерам придётся смириться с тем, что DevOps — это не панацея, а лишь способ переложить ответственность за стабильность системы на операционный отдел.

Оригинал статьи: https://arxiv.org/pdf/2602.15241.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- ЦБ смягчает хватку: что ждет рубль, акции и инвесторов в 2026 году (13.02.2026 23:32)

- Российский рынок акций: консолидация, риски и возможности в условиях неопределенности (11.02.2026 10:33)

- Infinix Note 60 ОБЗОР: плавный интерфейс, беспроводная зарядка, яркий экран

- 10 лучших игровых ноутбуков. Что купить в феврале 2026.

- Неважно, на что вы фотографируете!

- МосБиржа в ожидании прорыва: Анализ рынка, рубля и инфляционных рисков (16.02.2026 23:32)

- Лучшие ноутбуки с матовым экраном. Что купить в феврале 2026.

- Как научиться фотографировать. Инструкция для начинающих.

- Что такое Bazzite и лучше ли она, чем Windows для PC-гейминга? Я установил этот набирающий популярность дистрибутив Linux, чтобы проверить это самостоятельно.

- Лучшие ноутбуки с глянцевым экраном. Что купить в феврале 2026.

2026-02-18 12:21