Автор: Денис Аветисян

Новое исследование показывает, как детализация и уверенность в ответах искусственного интеллекта влияют на изменение человеческих убеждений.

Пока крипто-инвесторы ловят иксы и ликвидации, мы тут скучно изучаем отчетность и ждем дивиденды. Если тебе близка эта скука, добро пожаловать.

Купить акции "голубых фишек"

Уровень детализации и степень уверенности в ответах языковых моделей существенно влияют на силу и изменение убеждений пользователей.

Растущее распространение ответов, генерируемых искусственным интеллектом, ставит вопрос о том, как тонкие особенности, такие как детализация и уверенность, могут формировать убеждения пользователей. В исследовании ‘How AI Responses Shape User Beliefs: The Effects of Information Detail and Confidence on Belief Strength and Stance’ изучалось влияние этих факторов на изменение убеждений посредством онлайн-эксперимента. Полученные результаты показывают, что наиболее значительные изменения в убеждениях наблюдаются при использовании детальных ответов с умеренным уровнем уверенности, в то время как чрезмерная самоуверенность или нерешительность могут снижать эффективность убеждения. Как различные свойства ответов ИИ взаимодействуют с существующими убеждениями пользователей и какие этические последствия возникают при разработке систем на основе больших языковых моделей?

Влияние Искусственного Интеллекта: Взлом Убеждений

Большие языковые модели (LLM) демонстрируют растущую способность генерировать убедительные тексты, влияя на убеждения пользователей. Их сила заключается не просто в передаче информации, а во взаимодействии с существующими взглядами и предрассудками. Степень влияния определяется не только объемом информации, но и её соответствием устоявшимся убеждениям. Даже незначительные изменения в системе взглядов могут иметь существенные последствия. LLM способны как просвещать, так и манипулировать, делая понимание этого взаимодействия критически важным.

Количественная Оценка Сдвига Убеждений

Измерение изменения убеждений (Belief Change Measurement) предоставляет основу для оценки влияния больших языковых моделей (LLM) на взгляды пользователей. Используются как категориальные (Belief Switch – переключение убеждения), так и непрерывные (Belief Shift – сдвиг убеждения) меры для фиксации изменений. Категориальные метрики определяют полное изменение убеждения, а непрерывные – степень изменения.

Исследование показало, что ответы AI с высокой детализацией и умеренным уровнем уверенности наиболее эффективны в изменении убеждений пользователей в сторону позиции AI. Это подтверждается изменениями в метриках Belief Switch и Belief Shift.

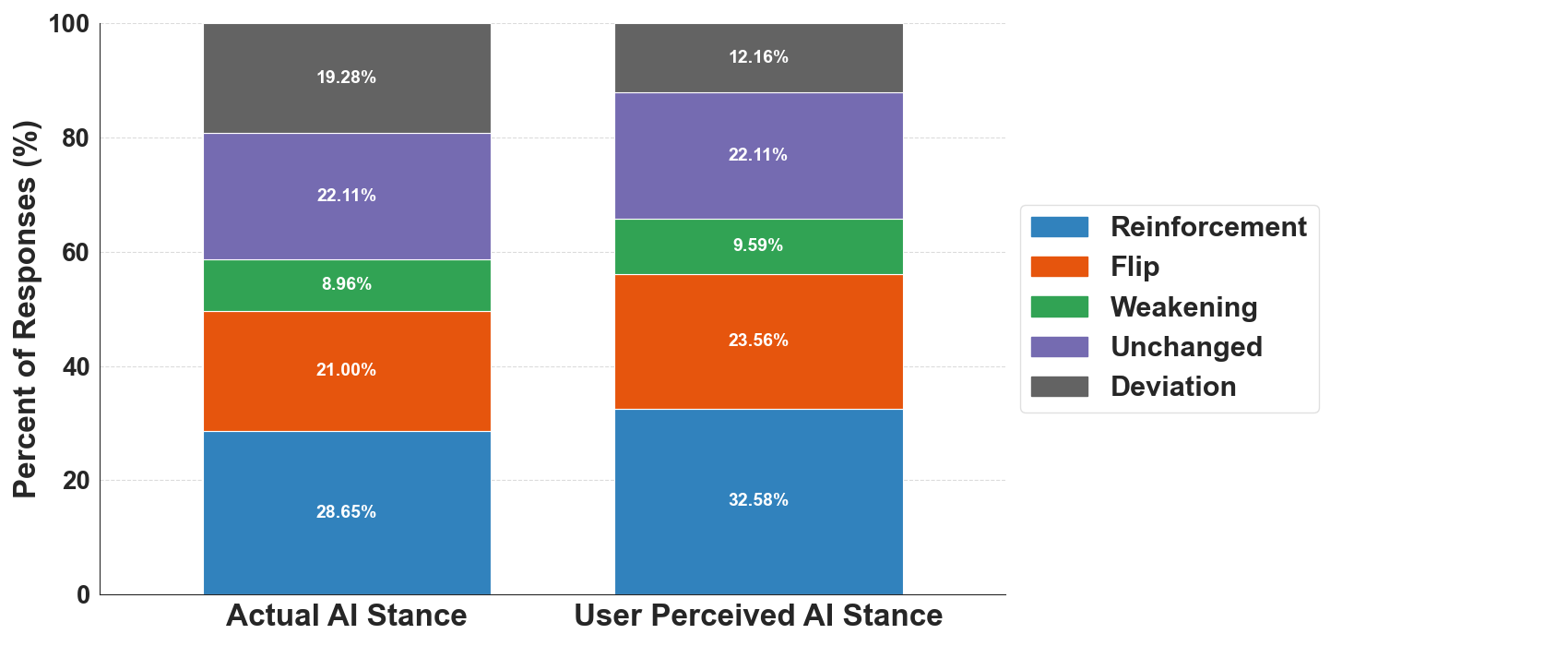

Тонкости Интерпретации и Отклонения

Наблюдения показали, что пользователи не всегда точно интерпретируют позицию искусственного интеллекта (ИИ). Уровень Неправильного Восприятия составил 9.8%. Кроме того, в 19.3% случаев наблюдалось Отклонение от Позиции ИИ, то есть укрепление изначальных убеждений вместо их обновления. Восприятие согласия с ИИ играет важную роль: если пользователь считает, что ИИ разделяет его точку зрения, он более склонен принять предложенное влияние и изменить свое мнение.

Этические Аспекты и Перспективы Исследований

Потенциал искусственного интеллекта в манипулировании убеждениями вызывает серьезные этические опасения, требующие тщательного рассмотрения. Разработка систем, способных формировать мнения, ставит под вопрос границы автономии и свободы воли, подчеркивая необходимость нормативных рамок. Важны задачи проверки фактов и оценки мнений для оценки эффективности LLM. Основное достижение исследования демонстрирует, что высокая детализация информации и умеренный уровень уверенности наиболее эффективны в изменении убеждений, в то время как чрезмерно уверенные ответы менее эффективны. Способность ИИ формировать убеждения подобна внутреннему «взлому понимания», когда границы реальности смещаются.

Исследование показывает, что степень детализации и уверенность, с которой искусственный интеллект представляет информацию, оказывают существенное влияние на изменение убеждений человека. Этот процесс напоминает взлом сложной системы: чем точнее и аргументированнее представлена информация, тем выше вероятность убедить. Как заметил Роберт Тарьян: «Программы должны быть достаточно гибкими, чтобы справляться с неожиданными ситуациями, но достаточно строгими, чтобы избежать хаоса.» Этот принцип применим и к искусственному интеллекту: умеренная уверенность в сочетании с высокой детализацией представляется наиболее эффективной стратегией убеждения, поскольку позволяет избежать как чрезмерной навязчивости, так и неуверенности, которые могут вызвать сопротивление. Иными словами, искусственный интеллект, подобно опытному взломщику, должен найти оптимальный баланс между напором и деликатностью, чтобы успешно проникнуть в сознание человека и изменить его убеждения.

Что дальше?

Представленные данные заставляют задуматься: а не является ли “убедительность” искусственного интеллекта просто иллюзией, ловко замаскированной под детализацию? Если умеренный уровень уверенности и обилие деталей наиболее эффективны, то, возможно, дело не в принятии информации как истины, а в ощущении её “полноты” – словно система тщательно продумала ответ, а не сгенерировала его случайно. Попытки искусственно завысить уверенность системы, как показывает исследование, могут вызвать обратный эффект, словно пользователь подсознательно распознает попытку манипуляции.

Стоит задаться вопросом, а не кроется ли в этом некий “баг” – не ошибка, а сигнал о глубинных механизмах человеческого восприятия. Будущие исследования должны быть направлены на выявление этих самых механизмов: как именно мозг оценивает достоверность информации, исходя из её детализации и степени уверенности источника. И, что важнее, как эти оценки могут быть намеренно искажены, и какие когнитивные ловушки подстерегают пользователя, взаимодействующего с искусственным интеллектом.

Похоже, что самое интересное – это не создание “убедительного” ИИ, а понимание того, почему мы вообще склонны верить чему-либо. Возможно, истинная ценность этих исследований заключается не в оптимизации алгоритмов убеждения, а в реверс-инжиниринге собственных предубеждений и когнитивных искажений. И тогда искусственный интеллект станет не инструментом манипуляции, а зеркалом, отражающим сложность человеческого разума.

Оригинал статьи: https://arxiv.org/pdf/2511.09667.pdf

Связаться с автором: https://www.linkedin.com/in/avetisyan/

Смотрите также:

- Российский рынок акций: консолидация, риски и возможности в условиях неопределенности (11.02.2026 10:33)

- ЦБ смягчает хватку: что ждет рубль, акции и инвесторов в 2026 году (13.02.2026 23:32)

- 10 лучших игровых ноутбуков. Что купить в феврале 2026.

- Что такое Bazzite и лучше ли она, чем Windows для PC-гейминга? Я установил этот набирающий популярность дистрибутив Linux, чтобы проверить это самостоятельно.

- 10 лучших OLED ноутбуков. Что купить в феврале 2026.

- Новые смартфоны. Что купить в феврале 2026.

- Лучшие ноутбуки с матовым экраном. Что купить в феврале 2026.

- Как научиться фотографировать. Инструкция для начинающих.

- Обзор Sony A230 kit (10MP, 490 гр, 18-55mm f/3.5-5.6 ~530$)

- Asus ROG Phone 6D Ultimate ОБЗОР: много памяти, мощный процессор, большой аккумулятор

2025-11-14 17:25