Примерно в середине 1900-х годов началась космическая гонка, а к середине 2020-х мы оказались в самом центре соревнования в области искусственного интеллекта. Никто не бездействует, поскольку организации из разных уголков мира активно стремятся к следующим революционным открытиям.

Пока крипто-инвесторы ловят иксы и ликвидации, мы тут скучно изучаем отчетность и ждем дивиденды. Если тебе близка эта скука, добро пожаловать.

Купить акции "голубых фишек"Китайские исследователи недавно объявили о разработке новой, высокоразвитой языковой модели под названием SpikingBrain1.0. В отличие от типичных языковых моделей, утверждается, что эта модель до 100 раз быстрее существующих моделей, таких как те, которые используются в ChatGPT и Copilot. Это новаторское достижение в области технологий искусственного интеллекта вызвало значительный интерес в научном сообществе.

Уникальная функциональность модели выделяет её, знаменуя собой новый подход, отличающийся от существующих моделей. Часто называемый новаторским ‘LLM, вдохновлённым нейронными сетями’, давайте разберёмся, что означает этот термин: Для ясности, вот некоторая информация о том, как функционируют обычные LLM.

Позвольте мне попытаться объяснить это более простым способом:

Современные языковые модели, часто называемые LLM, анализируют все предложение одновременно. Их задача — выявить закономерности и понять взаимосвязи между отдельными словами, независимо от их конкретного порядка в предложении.

В нем используется метод, известный как Внимание. Возьмите, к примеру, предложение вроде этого:

Бейсболист замахнулся битой и выбил хоум-ран.

Человек быстро понимает контекст предложения, поскольку его разум связывает слова, такие как ‘бейсбол’, с последующими без особых раздумий. С другой стороны, большая языковая модель может не различать бейсбольную биту и млекопитающее, известное как летучая мышь, основываясь только на слове ‘летучая мышь’. Только путем рассмотрения остальной части предложения она может точно различать значения.

Как аналитик языка, я сосредотачиваюсь на тщательном изучении целых предложений, чтобы понять их смысл. Для этого я устанавливаю связи между компонентами предложения, выявляя ключевые термины, такие как ‘раскачался’ и ‘игрок в бейсбол’. Понимая эти элементы, я могу точно определить значение, что в конечном итоге приводит к более точным прогнозам в моем анализе.

Обучающие данные для большой языковой модели включают случаи, когда слова ‘бейсбол’ и ‘бита’ часто встречаются вместе.

Обработка целых предложений сразу может быть ресурсоемкой, особенно для больших объемов входных данных. По мере увеличения объема данных, возрастает и потребность в ресурсах для понимания. Это частично объясняет, почему большинство современных языковых моделей требуют значительной вычислительной мощности. По сути, каждое слово сравнивается с каждым другим словом, что требует большого количества ресурсов.

SpikingBrain1.0 утверждает, что он эмулирует метод работы человеческого мозга, сосредотачиваясь на релевантных словах в предложении, подобно тому, как мы понимаем контекст предложения. В отличие от постоянной работы всего человеческого мозга, эта модель работает эффективно, активируя только необходимые нервные клетки по мере необходимости.

Как энтузиаст, я не могу не радоваться новой модели, которая обещает значительные улучшения! Это чудо техники, по словам ее разработчиков, должно увеличить эффективность в 100 раз по сравнению с существующими языковыми моделями (LLM). В отличие от чего-то вроде ChatGPT, эта модель разработана для выборочной реакции на входные данные, что, в свою очередь, снижает ее потребность в ресурсах для работы.

Как указано в исследовательской работе:

Используя этот метод, мы можем проводить непрерывное обучение, используя лишь небольшую часть данных (менее 2%), и при этом достигать производительности, сравнимой с известными моделями с открытым исходным кодом.

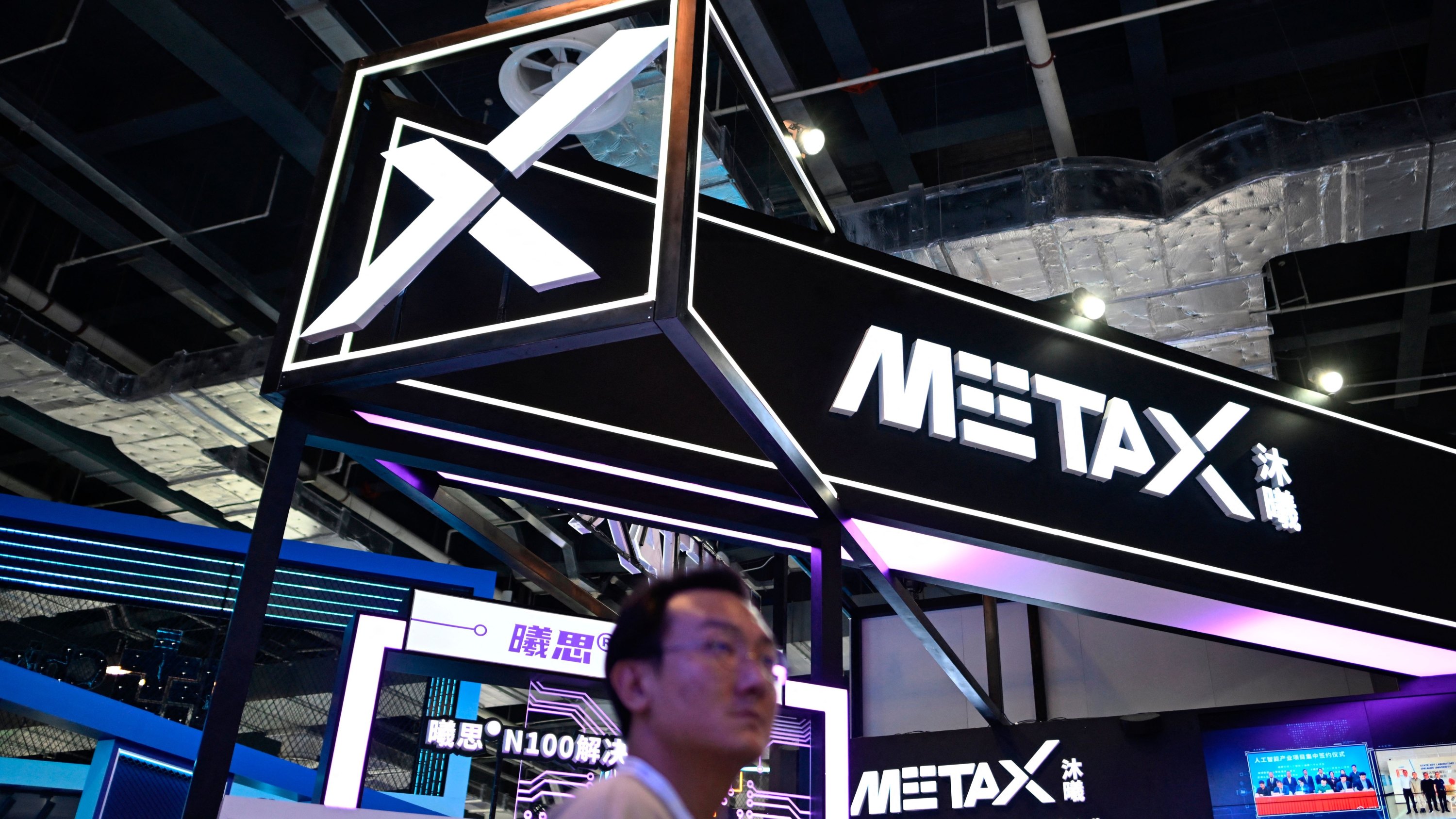

Как любитель технологий, я нахожу захватывающим тот факт, что эта модель не зависит исключительно от графических процессоров NVIDIA для своей вычислительной мощности. Вместо этого она успешно прошла тестирование с использованием разработанного компанией MetaX чипа из Китая.

Как любитель технологий, я вижу множество факторов, которые стоит обдумать, но теоретически, SpikingBrain1.0 может стать значительным шагом вперед в эволюции больших языковых моделей. Потенциальное влияние искусственного интеллекта на нашу окружающую среду неоспоримо, при этом огромное потребление энергии и столь же масштабные потребности в охлаждении этих гигантских центров обработки данных являются серьезными проблемами.

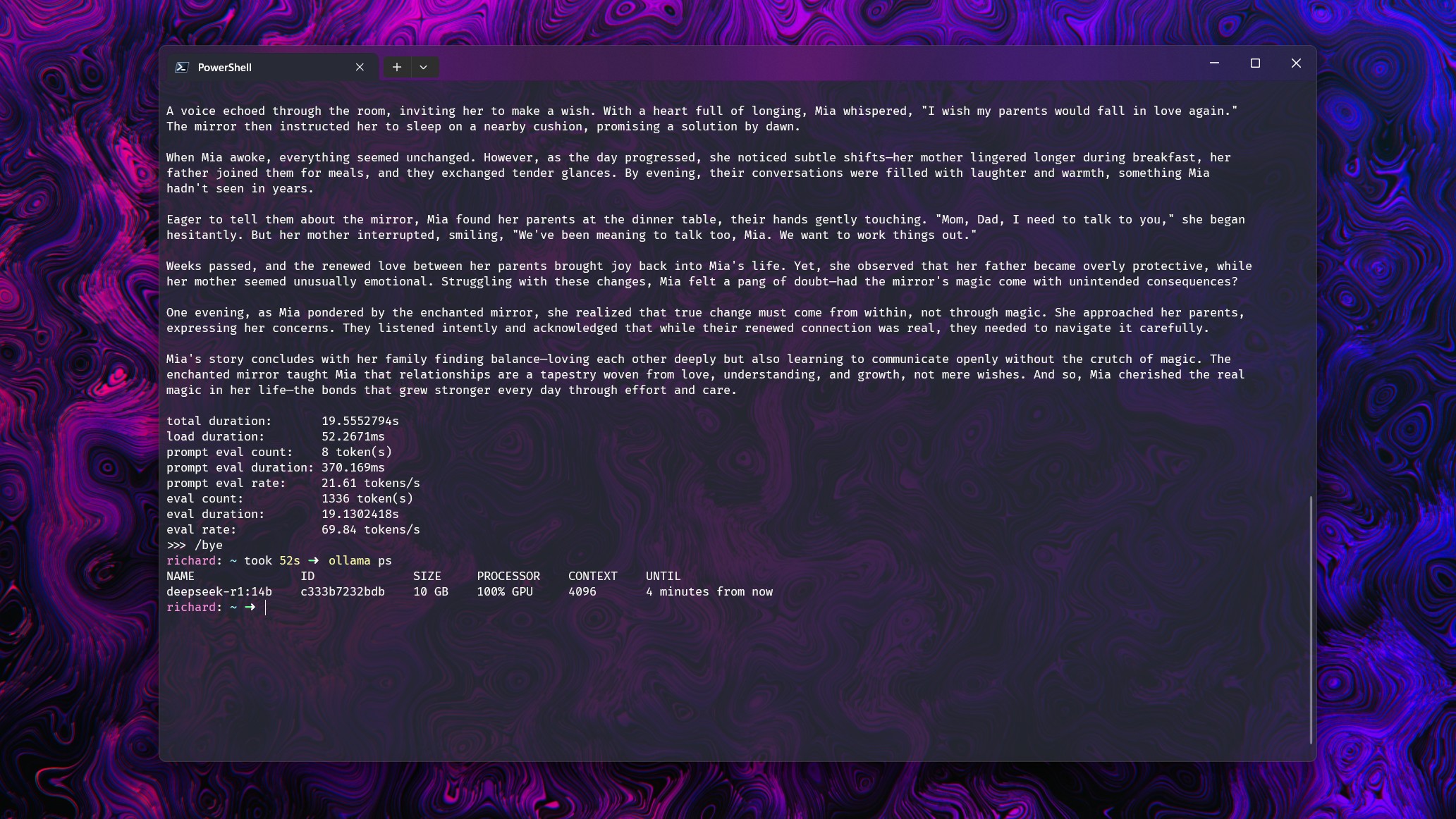

Запуск больших языковых моделей (БЯМ) на Ollama дома с RTX 5090 уже значительно нагревает мой дом, поскольку эта видеокарта потребляет почти 600 Вт и не отличается высокой энергоэффективностью. Если масштабировать это до дата-центра, заполненного аналогичными графическими процессорами, то производство тепла и потребление энергии, вероятно, станут неуправляемыми и неэффективными в гораздо большем масштабе.

Это новое достижение кажется многообещающим, при условии, что это действительно правда. Если оно обеспечит и точность, и эффективность, это может стать значительным шагом вперед. Определенно, впереди нас ждут захватывающие времена!

Смотрите также

- Российский рынок: Оптимизм на фоне трехсторонних переговоров – чего ждать 1 февраля? (25.01.2026 17:32)

- Российский рынок акций: рост золота и зерна поддерживают позитивный тренд (31.01.2026 10:32)

- Сургутнефтегаз акции привилегированные прогноз. Цена SNGSP

- Российский рынок акций: Ралли на фоне нефти, золота и смягчения ДКП (28.01.2026 16:32)

- Новые смартфоны. Что купить в январе 2026.

- CSAM используя стримера ‘Lacari’ пойман с поличным … Microsoft Notepad — опубликовал извинения и отрицание после получения перманентного бана.

- Неважно, на что вы фотографируете!

- Лучшие смартфоны. Что купить в январе 2026.

- Прогноз курса доллара к рублю на 2026 год

- Типы дисплеев. Какой монитор выбрать?

2025-09-12 15:09