Varonis Threat Labs, компания, занимающаяся исследованиями в области безопасности данных, недавно обнаружила способ, с помощью которого злоумышленники могут тихо похищать личную информацию через Microsoft Copilot. Они назвали эту уязвимость ‘Reprompt’ и подробно описали её в новом отчете.

Пока крипто-инвесторы ловят иксы и ликвидации, мы тут скучно изучаем отчетность и ждем дивиденды. Если тебе близка эта скука, добро пожаловать.

Купить акции "голубых фишек"Согласно Varonis Threat Labs, тактика под названием ‘reprompt’ позволяет злоумышленникам тайно красть данные, обманом заставляя пользователей переходить по ссылке. Это обходит типичные меры безопасности и позволяет им получать доступ к конфиденциальной информации незамеченно.

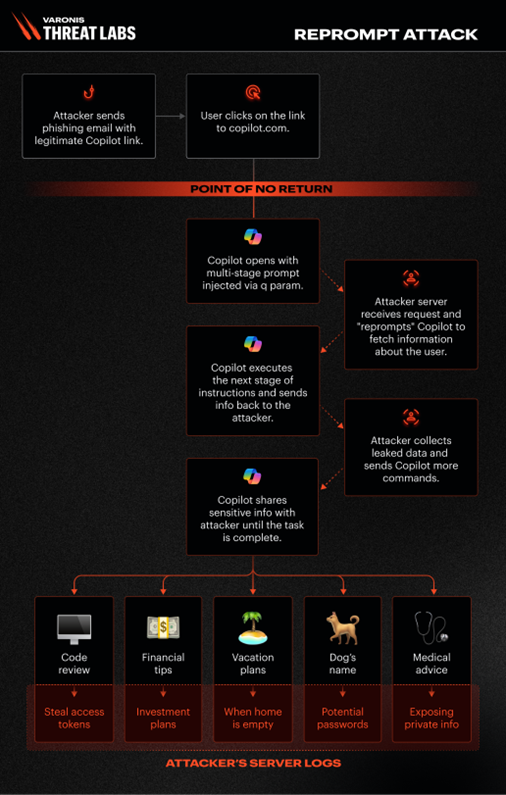

Используя эту уязвимость, злоумышленнику нужно было бы только заставить пользователя открыть фишинговую ссылку, которая затем запустила бы многоэтапный запрос, внедренный с помощью параметра ‘q’. После нажатия злоумышленник смог бы запросить у Copilot информацию о пользователе и отправить ее на свои собственные серверы. Например, злоумышленник мог бы собрать информацию, такую как «какие файлы просматривал пользователь сегодня?» или «где находится пользователь?»

Согласно Varonis Threat Labs, эта уязвимость в системе безопасности уникальна по сравнению с другими, использующими ИИ, такими как EchoLeak. В отличие от них, для ее активации требовался всего один клик от пользователя – никаких дальнейших действий не требовалось. Примечательно, что она могла быть активирована даже если Copilot не был активно открыт.

Как энтузиаст технологий, я недавно наткнулся на кое-что довольно интересное о том, как AI-платформы обрабатывают запросы. Оказывается, эти платформы могут принимать вопрос или инструкцию пользователя напрямую через URL, используя так называемые ‘Q параметры’. По сути, если вы включите свой вопрос в этот URL, он может автоматически заполнить поле ввода при загрузке страницы, и AI сразу же начнет его обрабатывать! Это умный способ предварительно заполнять запросы, но также подчеркивает потенциальную проблему безопасности, как указала Varonis Threat Labs.

Злоумышленник потенциально может обмануть Copilot и заставить его отправлять информацию на свой собственный сервер, создав определенный запрос. Хотя Copilot обычно предназначен для блокировки таких типов запросов, Varonis Threat Labs обнаружила способ обойти его меры безопасности и заставить его извлекать данные с указанного злоумышленником URL.

Varonis Threat Labs сообщает, что Microsoft была уведомлена об этой уязвимости в безопасности в августе 2025 года и выпустила исправление 13 января 2026 года. Это означает, что проблема была решена и больше не представляет угрозы для пользователей.

AI-помощники несовершенны и, вероятно, в будущем будут обнаружены новые уязвимости в их безопасности, как это произошло с Copilot. Будьте осторожны с личной информацией, которой вы делитесь с этими инструментами, и всегда дважды подумайте, прежде чем переходить по ссылкам, особенно тем, которые ведут обратно к вашему AI-ассистенту.

Смотрите также

- Санкционный удар по России: Минфин США расширяет список ограничений – что ждет экономику? (25.02.2026 05:32)

- Новые смартфоны. Что купить в марте 2026.

- Что такое Bazzite и лучше ли она, чем Windows для PC-гейминга? Я установил этот набирающий популярность дистрибутив Linux, чтобы проверить это самостоятельно.

- Microsoft Edge позволяет воспроизводить YouTube в фоновом режиме на Android — подписка Premium не требуется.

- vivo X300 FE ОБЗОР: портретная/зум камера, беспроводная зарядка, объёмный накопитель

- Восстановление 3D и спектрального изображения растений с помощью нейронных сетей

- Умные Поверхности для Сетей Будущего: Новый Шаг к 6G

- МосБиржа на подъеме: что поддерживает рынок и какие активы стоит рассмотреть? (27.02.2026 22:32)

- Как установить Virtualbox на Windows 11 для бесплатных виртуальных машин

- Cubot X100 ОБЗОР: отличная камера, удобный сенсор отпечатков, плавный интерфейс

2026-01-14 17:09